웹개방성

웹개방성(Web Openness)이란 인터넷 웹사이트에 검색엔진 로봇이 쉽게 접근하여 정보를 수집해 갈 수 있도록 개방하는 것을 말한다. 개인정보보호, 기밀보안 등의 이유로 검색엔진 접근을 배제할 경우, 검색 포털 사이트를 통해 해당 웹사이트에 실린 정보를 찾기 어렵기 때문에 웹개방성이 저하된다. 반대로 신디케이션 API(Syndication API)를 사용할 경우 웹사이트의 수정사항이 즉시 검색 포털 사이트에 전달되어 웹개방성을 극대화할 수 있다.

| [아사달] 스마트 호스팅 |

개요[편집]

웹개방성이란 웹에 공개된 정보에 이용자가 아무런 제약 없이 접근하여 이용할 수 있는 것을 의미하며, 웹사이트의 정보를 자유롭게 공개ㆍ공유하여 정보의 투명성과 개방성이 향상되는 것을 말한다. 한국은 세계에서 가장 빠른 인터넷 환경과 전 세계 4위에 달하는 스마트폰 보급률로 정확한 정보를 쉽고 빠르게 얻을 수 있는 훌륭한 정보 환경에서 살고 있다. 그만큼 좋은 정보들에 정확하게 접근하는 것 역시 중요하다. 검색이 정확히 이뤄지지 않는 정보들은 쓸모없는 정보와 다를 바 없기 때문이다. 우리는 구글, 네이버, 다음 등의 포털사이트에서 많은 양의 데이터를 검색하며 살고 있지만, 실제로는 매우 제한적인 검색이 이뤄지고 있다. 그 이유는 검색엔진 배제 선언에 있다. 일반적으로 검색로봇이 웹사이트의 정보를 수집하는 알고리즘에서 검색엔진 배제선언을 하게 되면, 웹사이트에 검색 로봇의 접근을 막아 정보를 수집할 수 없게 되는 것이다. 그래서 2011년에 행정안전부, 현 행정자치부에서 검색 로봇 배제 표준 적용 방법 가이드라인을 배포했다. 웹개방성의 수준을 체계적으로 강화해 개인정보와 같은 중요 정보는 검색할 수 없도록 하고, 필요한 자료는 효율적으로 개방할 수 있게 만드는 가이드라인이지만, 대부분의 웹사이트에서는 이러한 가이드라인을 준수하는 비율이 낮다.[1]

단순히 검색엔진에 키워드를 입력하는 것만으로도 웹사이트 내의 내용을 모두 찾을 수 있으면, 웹개방성이 높은 것으로, 해당 웹사이트에 일일이 접속해 원하는 내용을 찾아야 하면 웹개방성이 낮은 것으로 간주한다. 국내의 웹개방성은 낮은 편으로, 국내의 대학교, 학술/연구기관은 정보 접근을 완전히 차단하여 검색으로 정보를 찾을 수 없게 해뒀다. 정보를 얻는 대부분의 사람의 특성상 양질의 정보가 있더라도 얻기 힘들다.[2] 이처럼, 웹개방성이 낮으면 양질의 자료가 있더라도 검색으로 자료를 찾을 수 없기에 검색으로 나온 자료만을 사용하거나, 양질의 자료를 얻고 싶다면 일일이 다 뒤져서 정보를 찾아야 하는 수고스러움을 동반한다. 그러므로 웹개방성을 높여 양질의 정보를 공유하는 것이 중요하다.

특징[편집]

필요성[편집]

웹개방성 측면에서 웹사이트 검색을 전체 차단하거나 부분 차단하는 것은 정보수집 및 검색에 영향을 미치는 것으로 이는 웹개방성 위배에 해당한다. 또한 검색엔진의 접근을 차단하면 국민들이 검색엔진을 통해 원하는 각 해당 사이트의 정확하고 자세한 정보를 찾을 수 없게 된다. 즉, 검색엔진 배제선언(robots.txt)은 보안을 위한 도구가 아닌 약속된 선언에 불과해 부분차단을 사용하게 되면 오히려 해킹의 타겟(target)이 될 수도 있어 보안에 위협이 될 수 있으므로 부분차단은 하지 않는 것이 중요하다. 숙명여자대학교 경영전문대학원 주임교수 겸 웹발전연구소 대표인 문형남 교수는 “웹사이트에 정보를 공개해놓고 검색엔진의 접근을 차단하는 것은 매우 잘못된 것이고, 정보가 많은 웹사이트를 무용지물로 만드는 것이다. 검색에 큰 영향을 미치는 검색엔진 배제선언을 통해 검색을 완전 차단 또는 부분 차단한 것은 대부분 검색엔진 차단의 의미를 제대로 알지 못하고 개인정보보호나 보안에 도움이 되는 줄로 잘못 알고 있기 때문”이라고 말했다. 또한 그는 “공공기관이 검색엔진의 접근을 차단하는 것은 국민의 정보 접근을 차단하는 것과 마찬가지이며, 주요 고객인 국민들을 공개된 정보에 빠르고 쉽게 접근하지 못하고 여러 번 시행착오를 겪고 나서야 접근하게 하는 것은 하루빨리 개선돼야 한다”라고 강조했고, “행정기관과 공공기관의 모든 대국민 사이트에서 제공하는 공공정보는 높은 가치를 지닌 중요한 자산이므로 모두 검색엔진 접근을 완전히 개방하여 적극적으로 활용돼야 하며, 국민과의 소통과 대국민 홍보 효과가 기대된다”라고 말했다. 그는 “공공기관들이 웹사이트의 정보 검색을 차단한 것은 국민들에게 불편을 주며 예산을 낭비하는 것이므로 즉시 시정돼야 하며, 공공기관 평가 항목에 웹개방성 항목을 반드시 추가해서 반영해야 한다”고 주장했다.[3]

웹사이트 개방 확인 방법[편집]

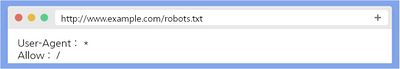

- robots.txt 파일

로봇 차단을 확인할 때는 웹사이트에 접속한 후 브라우저 주소창에 해당 웹사이트의 주소 뒤에 /robots.txt를 추가로 입력하고 엔터키를 누른 뒤 해당 페이지에 나타나는 결과에 따라 로봇을 배제하는지 안 하는지를 확인할 수 있다. robots.txt가 존재하지 않는다면 화면에 Not Found라는 글자가 출력되고, 이는 모든 로봇에 대한 문서 접근을 허용하는 형태이다. 또 다른 형태로는 User-Agent와 Allow가 출력된다. User-Agent에서 *은 모든 로봇을 지칭하는 뜻이며, Allow에서 /는 모든 디렉터리에서 로봇의 접근을 허용한다는 뜻이다. Allow 대신 Disallow:/ 형태로 되어있으면, 검색 로봇이 모든 문서에 접근할 수 없도록 차단한 상태이다. 부분적으로 차단도 가능하다.[4]

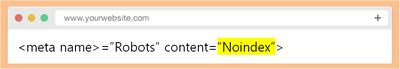

- Noindex / Nofollow 태그 확인

noindex / nofollow 태그는 해당 웹페이지에서 마우스 우측 클릭 시 '소스보기'에서 해당 태그가 포함되어 있는지를 Ctrl+F키로 검색하여 쉽게 확인할 수 있다. noindex는 색인이 되지 않도록 하고, nofollow는 해당 웹페이지에 포함된 링크를 따라가지 않도록 하는 역할을 한다. 다음 그림은 검색 엔진이 문서 정보를 알 수 있도록 안내하는 역할을 하는 Meta 태그의 Content 속성 중 noindex는 해당 페이지에 대한 색인작업(index)을 제외하는 역할로, 로봇이 색인을 못 하게 되면 해당 페이지에 대한 정보가 저장되지 않기 때문에 검색에서 제외된다. Content 속성 중 nofollow를 설정하게 되면 검색 로봇이 해당 페이지에 수록된 링크를 따라갈 수 없게 제한하여 효율적인 검색을 방해할 수 있다.[4]

- URL 공개 또는 비공개 여부 확인

웹사이트와 그 안에 포함된 내용은 고유의 URL을 가지고 있다. 다만, 해당 페이지의 URL이 변경되었음에도 주소창의 URL이 변하지 않는 경우, 검색 로봇은 이를 인식하지 못해 검색이 제한될 수 있다.[4]

웹개방성 지수[편집]

웹개방성 지수(WOI, Web Openness Index)란 웹개방성을 평가하기 위해 웹 발전연구소에서 최초로 개발한 평가모형으로, 웹사이트의 검색엔진 접근 차단, 특정 페이지 접근 차단, 페이지별 정보 수집 거부 등을 평가해 점수화한 것이다.

- 웹개방성 지수 개발 및 고도화

- 2012.06 : 웹 개방성 평가모형 WOI 1.0 개발 / 4개 항목: robots.txt blocking, Noindex/nofollow blocking, Redirecting to install ActiveX and Java, JavaScript errors

- 2012.11 : WOI 1.0을 고도화하여 WOI 2.0 개발 / 6개 항목: robots.txt blocking, User-agent blocking, Noindex/nofollow blocking, POST method pages, Redirecting to install ActiveX and Java, ActiveX/Flash/JavaScript links

- 2013.06 : WOI 2.0을 고도화하여 WOI 3.0 개발 / WOI 2.0을 전문성, 신뢰성이 강화된 WOI 3.0으로 고도화하였으며 각 평가항목의 성격을 표현할 수 있도록 6개 항목명 변경 및 평가대상, 가중치 등 업그레이드[5]

- WOI 3.0 평가 항목 및 설명

- 검색엔진 접근 차단

웹 방화벽이나 웹 서버의 운영 정책에 따라 특정 검색엔진의 접속이나 특정 내용에 대한 접근 및 열람을 필터링을 통해 차단한다.

- 검색엔진 배제선언

웹 루트 디렉터리에 저장한 robots.txt 파일에 검색엔진 접근 거부에 대한 정책을 선언함으로써 거부 선언된 검색엔진이 방문 시 이를 통해 검색을 수행하지 않는다.

- 특정 페이지 접근 차단

웹사이트 초기 접속 시 액티브X, 자바 등의 실행을 목적으로 하는 특정 웹페이지로 접속을 연결함으로써 검섹엔진의 웹사이트 크롤링이 불가능하다.

- 페이지별 정보 수집 거부

웹페이지 소스코드에 검색엔진 접근 거부에 대한 정책을 선언함으로써 거부 선언된 검색엔진이 이 웹페이지에 대해서는 검색을 수행하지 않는다.

- 신기술 적용에 의한 차단

웹사이트의 특정 콘텐츠 영역이나 링크 정보를 플래시(Flash), 자바 애플릿(JAVA Applet), 자바스크립트(JAVA Script), 이미지 파일 등으로 구현함으로써 해당 영역의 검색을 차단한다.

- 페이지별 URL 차단

검색엔진이 웹 서버의 구현 특성에 따라 웹사이트의 하부 웹페이지 URL을 추출하지 못하여 발생하는 검색을 중단한다.[6]

- 웹개방성 평가 목적 및 기대효과

웹에 공개된 정보는 높은 사회, 경제적 가치를 지닌 중요한 자산으로 합리적인 정보 공개가 필요하다. 웹사이트의 정보 접근성 향상과 정보 개방에 대한 정보 제공자 측의 인식 제고 및 개선이 목적이며, 정보 개방에 대한 공공과 민간 기업 등 정보 제공자 측의 인식 개선과 참여 공유 투명성 제고, 정보 공개로 사용자의 합리적인 정보 활용도 향상, 정보의 자유로운 흐름 측면에서의 웹 정보 접근성 향상, 효율적인 웹 정보 제공이 가능하며 이를 통한 비용 절감 효과 기대, 향상된 각 웹사이트의 정보 제공으로 스마트 미디어 시대의 웹 서비스를 선도, 개방된 정보를 사회ㆍ경제적 가치가 높은 자산으로 활용하여 새로운 경제적 효과 창출 등이 있다.[7]

월드와이드웹(World Wide Web)의 창시자인 팀 버너스 리(Tim Berners-Lee)는 TED에 연사로 나와 열린 데이터(Linked Data)의 중요성을 역설했다. 이제 페이지 단위를 넘어 개별 데이터 단위로 열린 웹을 만들자는 내용이었다. 이것은 온라인에 존재하는 작은 데이터들이 모여 삶에 기여하게 되는 모습을 의미하고, 정보가 유의미하게 연결되는 것만으로 곧 가치 있는 힘이 된다고 말했다. 이것을 실현하기 위해 필요한 것은 더 이상 데이터 끌어안기(Data hugging)를 하지 말아야 한다는 당부였다. 즉, 폐쇄적인 콘텐츠 운영을 통해 정보의 소유자만 데이터를 갖고 있으려는 정책은 그 누구에게도 도움이 되지 않을 것이다. 실제로, 국내의 대학교/대학원에서는 매년 수 많은 연구가 행해지고 있음에도 연구 정보를 공개하는 곳은 극히 드물다는 것을 알 수 있다. 이로 인해 학교, 학과, 학년, 개인별로 비슷한 연구가 중복될 수밖에 없는 실정이다. 그렇다면 그것은 개인이나 국가뿐만 아니라 인류 전체를 위해서도 큰 낭비가 아닐 수 없다. 서로에게 정보가 공유된다면 연구 시간을 단축할 수 있고, 비용도 절감할 수 있게 될 것이다. 지금 이 글을 읽고 있는 당신도 어딘가를 통해 연결되어 왔기 때문에 지금 이 글을 읽을 수 있는 것이다. 포털 사이트의 검색 결과에서 발견되지 않았거나, 아무리 노력해도 찾을 수 없었다면 이 글은 그만큼의 독자를 잃을 수밖에 없다. 돈을 들여 광고하고 사용자를 끌어들이는 것만이 최선은 아니다. 사용자의 의도에 맞게 콘텐츠를 제공하고, 사용자가 쉽게 찾을 수 있다면 정보는 제때 소비되고 사업자 입장에서 비용도 그만큼 아낄 수 있게 된다. 이제 우리는 정보를 게재하는 데 그치는 것이 아니라, 어떻게 하면 많은 사람이 정보에 접근할 수 있을지를 우선으로 고민해야 하는 때가 왔다.[8]

- 딥러닝에서의 기대효과

2016년, 이세돌과 알파고의 바둑 대결이 큰 주목을 받았었다. 로봇과 인간의 대결이라는 타이틀만으로도 매우 흥미로웠고, 결론적으로 양측 모두에게 이로울 수 있는 성적을 내며 마무리되었다. 알파고라는 프로그램이 바둑 고수를 위협할 수 있는 경지에까지 이를 수 있었던 이유는 딥러닝(Deep learning)을 통해 그간 사람이 펼쳤던 무수한 기보들을 수집하여 학습하고 진화해왔기 때문이다. 만약 사람이 펼쳤던 바둑 경기의 정보가 개방되지 않아 정보를 수집하기 어려운 상황이었다면, 학습 자체가 불가능에 가깝기에 알파고가 이기기는커녕, 딥러닝이라는 기술 자체를 시도하지도 못했을 것이다.[8] 이런 면에서, 웹개방성이 높으면 높을수록 딥러닝으로 학습할 데이터가 많아지기에 4차 산업혁명을 이끌어가는 인공지능의 진화를 기대할 수 있다.

현황[편집]

웹사이트에 올라온 공개된 정보는 누구나 손쉽게 검색하고 접근해서 볼 수 있어야 한다. 공개된 정보에 접근을 차단할 아무런 이유가 없다. 그런데 정보 접근을 차단하면 개인정보 보호나 보안에 도움이 되는 것으로 잘못 알고 있거나, 차단한 줄도 모르고 차단해 놓은 웹사이트가 적지 않다.[9] 웹개방성 평가ㆍ인증기관인 웹발전연구소가 기타 공공기관 147개 웹사이트의 웹개방성을 조사한 결과 56곳의 웹개방성이 매우 미흡 또는 미흡한 것으로 나타났다. 전체 허용은 91개(61.9%), 부분 차단은 40개(27.2%), 전체 차단은 16개(10.9%)인 것으로 나타났다. 문형남 교수는 “개인정보보호·보안은 웹개방성과 별개 문제인데, 일부 기관과 업체들이 보안에 대한 잘못된 인식과 고정관념으로 인해 정보 접근을 차단하는 것은 시정되어야 하며, 각 기관 담당자들의 웹 정보 개방에 대한 인식을 개선하여 사용자들의 정보 접근성을 높여야 한다”고 강조했다. 또한 “공공기관뿐만 아니라 민간 기업에서도 웹개방성을 준수하는 것이 바람직하다”라고 말했다. 문 교수는 “행정기관과 공공기관의 담당자 및 웹사이트 제작사들이 잘 모르고 웹개방성을 준수하지 않는 경우가 많다”면서 “행정기관과 공공기관 및 모든 대국민 웹사이트들의 웹개방성이 준수될 때까지 지속해서 평가해서 결과를 발표해 개선되도록 하겠다”고 덧붙였다.[3]

각주[편집]

- ↑ 써미, 〈(최신 웹 기술 사례) 웹 개방성의 이해와 필요성〉, 《네이버 블로그》, 2016-05-11

- ↑ 강일용, 〈여전히 형편없는 국내 웹개방성... 대학, 연구기관 78%가 검색 제한〉, 《아이티동아》, 2013-03-11

- ↑ 3.0 3.1 문형남 전문기자, 〈기타 공공기관 147개 웹 개방성평가, 38.1%인 56개 기관 검색 차단〉, 《뉴스퍼스트》, 2020-05-26

- ↑ 4.0 4.1 4.2 광고컬럼, 〈23. 검색이 잘 되는 비밀! 웹 개방의 필요성〉, 《플레이디》, 2013-10-04

- ↑ 웹발전연구소 - http://www.smartebiz.kr/pages/subpage03_04.html

- ↑ 웹 개방성 인코덤 - http://www.incodom.kr/%EC%9B%B9_%EA%B0%9C%EB%B0%A9%EC%84%B1

- ↑ 웹발전연구소 - http://www.smartebiz.kr/new/subpage03_01.html

- ↑ 8.0 8.1 uiux lab, 〈Web Openness(웹 개방성), 차세대 웹을 위한 모두의 준비〉, 《네이버 블로그》, 2016-03-17

- ↑ 문형남 숙명여대 경영전문대학원 주임교수, 〈(시시비비)웹 개방성 준수, 법제화가 필요하다〉, 《아시아경제》, 2019-08-22

참고자료[편집]

- 웹 소울 랩 - http://www.websoul.co.kr/consulting/woi.asp

- 광고컬럼, 〈23. 검색이 잘 되는 비밀! 웹 개방의 필요성〉, 《플레이디》, 2013-10-04

- 웹 개방성 인코덤 - http://www.incodom.kr/%EC%9B%B9_%EA%B0%9C%EB%B0%A9%EC%84%B1

- 웹발전연구소 - http://www.smartebiz.kr/new/subpage03_01.html

- 문형남, 〈(문형남 칼럼) 행정ㆍ공공기관 웹사이트 검색 전면 개방하라〉, 《아주경제》, 2020-02-02

- 문윤홍 대기자, 〈웹발전연구소 "한전기술 등 7곳 웹개방성 '미흡'" 평가〉, 《매일종교신문》, 2019-09-16

- 문형남 전문기자, 〈기타 공공기관 147개 웹 개방성평가, 38.1%인 56개 기관 검색 차단〉, 《뉴스퍼스트》, 2020-05-26

- 이민우 기자, 〈한전 등 공기업 8곳 웹개방성 취약〉, 《아시아경제》, 2019-08-26

- 문형남 숙명여대 경영전문대학원 주임교수, 〈(시시비비)웹 개방성 준수, 법제화가 필요하다〉, 《아시아경제》, 2019-08-22

- uiux lab, 〈Web Openness(웹 개방성), 차세대 웹을 위한 모두의 준비〉, 《네이버 블로그》, 2016-03-17

같이 보기[편집]

| ||||||||||||||||||||||

해시넷

해시넷