코헨 자기조직 신경망

코헨 자기조직 신경망(kohonen self-organizing map)은 핀란드 헬싱키 공과대학교(Helsinki Technology University)의 튜보 코호넨(Teuvo Kohonen)에 의해 제안된 대뇌피질의 시각피질을 모델화한 인공신경망의 일종이다. 비지도학습에 의한 클러스터링(clustering) 방법의 하나이며, 자기조직화 맵(SOM)이라고도 한다.

목차

개요[편집]

코헨 자기조직 신경망은 튜보 코호넨에 의해 제안된 인공신경망이다. 그의 연구 업적은 유럽에서만큼 미국에서는 크게 알려지지 않았으나, 자율적인(unsupervised) 신경망 모델에서는 미국의 그로스버그(S. Grossberg)와 더불어 가장 유명하다. '자기조직화'(self-organizing)란 주어진 입력 패턴에 대하여 정확한 해답을 미리 주지 않고 자기 스스로 학습할 수 있는 능력을 말한다. 일반적으로 이러한 네트워크들은 신경 생리학적인 시스템을 본따서 모델링한 것이다.[1] 코헨 자기조직 신경망은 일반적으로 2차원을 생산하기 위해 비지도학습을 이용해 훈련하는 일종의 인공신경망으로, 훈련 샘플의 입력 공간을 탈피하여 표현하며 치수 축소를 하는 방법이다. 코헨 자기조직 신경망은 오류 수정 학습(구배 강하 역제안 등)과 반대로 경쟁 학습을 적용하고, 입력 공간의 위상적 특성을 보존하기 위해 근린 기능을 사용한다는 점에서 다른 인공신경망과 다르다.[2] 코헨 자기조직 신경망은 두 가지의 층으로 구성된다. 첫 번째 입력층(input layer)이고, 두 번째 층은 2차원의 격자(grid)로 된 경쟁층(competitive layer)이다. 입력층과 경쟁층은 서로 연결되는데, 코헨 자기조직 신경망에서 연결 강도는 가중치(weight)로 나타내고 통상적으로 0과 1 사이의 정규화(normalize)된 값을 사용하며 학습을 통해 적절하게 초기화된다. 코헨 자기조직 신경망은 경쟁 학습(competive Learning)을 통해 입력층과 경쟁층이 연결된다. 연결 강도는 입력 벡터가 얼마나 가까운지 계산을 통해 가까운 뉴런이 승리하게되는, ‘승자 독점'(winner take all)방식을 사용한다. 가장 가까운 뉴런으로 계산되면 그 뉴런의 이웃 뉴런들도 학습을 하게 되는데, 네트워크의 모든 뉴런들이 아닌 제한된 이웃 뉴런들만 훈련하는 방식이다. 이 때, 층 내의 근접한 노드들은 ‘측면 제어'(lateral inhibition)를 사용하는데, 독점한 노드의 이웃 노드들을 거리상으로 보면 멕시칸 모자(sombrero) 형태로 나타난다.[3]

특징[편집]

경쟁 학습[편집]

코헨 자기조직 신경망의 학습에서 각 뉴런은 연결 강도 벡터와 입력 벡터가 얼마나 가까운가를 계산한다. 그리고 각 뉴런들은 학습할 수 있는 특권을 부여받으려고 서로 경쟁하는데, 거리가 가장 가까운 뉴런이 승리하게 된다. 이 승자 뉴런이 출력 신호를 보낼 수 있는 유일한 뉴런이다. 또한 이 뉴런과 이와 인접한 이웃 뉴런들만이 제시된 입력 벡터에 대하여 학습이 허용된다. 이것은 학습에 있어서 전혀 새로운 접근 방식이다. 이 모델이 있기 이전에는 네트워크에 있는 모든 뉴런들이 반복되는 훈련 과정에서 연결강도를 조정한다. 이것을 경쟁 학습(Competitive Learning)이라고 한다.

코헨 자기조직 신경망의 학습 철학은 '승자 독점(winner take all)' 이다. 승자만이 출력을 낼 수 있으며, 승자와 그의 이웃들만이 그들의 연결 강도를 조정할 수 있다. 생물학적 모델로 디자인된 코헨 자기조직 신경망의 시스템은 층(layer) 내에서 경쟁하는 복잡한 스킴(scheme) 인 '측면제어'(lateral ingibition)를 사용한다. 전체적인 측면제어 효과는 멕시칸 모자와 유사하다. 이웃 반경의 정확한 크기는 바로 인접한 뉴런들에게만 해당되도록 제한될 필요는 없다. 이웃 반경의 크기는 학습하는 도중에도 변할 수 있다. 처음에는 층내의 모든 뉴런들을 포함하다가 점차로 줄어들어 승자와 바로 인접한 뉴런들만이 포함된다. 승자 뉴런의 연결강도 백터는 입력백터의 가장 가까운 것이다. 왜냐하면 그렇지 않다면 경쟁에서 승자가 될 수 없었기 때문이다. 이 뉴런과 그의 이웃 반경 안의 뉴런들은 연결 강도를 조정해 가면서 학습을 한다. 이러한 측면 제어의 개념은 생물학적인 모델에서 매우 중요하다.[1]

학습 규칙[편집]

승자 뉴런을 결정하고 난 후에는 코헨 자기조직 신경망의 학습 규칙(Learning Rule)에 따라 뉴런의 연결 강도를 조정해야 한다. 이 규칙은 다음 식으로 표현된다.

여기서 는 조정되기 이전의 연결 강도 벡터이며, 는 조정된 후의 새로운 연결 강도 벡터이고, 는 입력패턴 벡터이며, 는 학습 상수이다.

앞에서 기술한 바와 같이 승자 연결 강도 벡터는 기하학적으로 입력패턴에 가장 가깝다. 코헨 자기조직 신경망의 학습은 단순히 연결 강도 벡터와 입력 패턴 백터의 차이를 구한 다음, 그것의 일정한 비율을 원래의 연결 강도 벡터에 더하는 것이다. 이때 승자 뉴런만이 그것과 관련된 벡터를 조정하는 것이 아니라 그의 이웃 반경 안에 드는 모든 뉴런들도 유사한 조정을 하게 된다. 승자 뉴런은 +1 을 출력으로 내며, 승자 뉴런과 그것의 이웃 뉴런들은 각자의 연결 강도 벡터를 입력 벡터에 다소나마 가까이 접근하게 된다.

일반적으로 코헨 자기조직 신경망에서 승자 뉴런의 이웃 반경은 서서히 줄어든다. 학습의 거의 모든 뉴런들이 학습을 하게 된다. 훈련이 진행됨에 따라 이웃 반경은 서서히 줄어들어서 점점 적은 갯수의 뉴런들이 학습을 하게 된다. 최종적으로는 단지 승자 뉴런만이 그것의 연결 강도를 조정하게 된다. 이러한 과정이 끝나면 또 다른 입력 벡터가 들어오게 되고 위에서 기술한 과정을 되풀이한다. 즉 새로운 승자 뉴런이 선택되고, 출력 신호를 내고, 승자 뉴런과 그 이웃 반경의 뉴런들의 연결 강도 벡터는 입력 벡터에 다가가게 된다. 이러한 과정은 모든 훈련이 끝날 때까지 계속 반복된다.

코헨 자기조직 신경망의 학습 규칙에 대한 역사는 복잡하다. 이 학습 규칙 자체는 1962년이나 그 이전에 생겨났으며, 1965년 닐슨(Nils Nilsson)의 러닝 머신(Learning Machine)이라는 저서에도 나타나 있다. 이 책에서 닐슨은 이 학습 방법이 1962년 스타크(L.M.Stark), 오카지마(M, Okajima), 그리고 위플(G.H.Whipple) 등에 의해 발명되었다고 주장하고 있다. 실제로는 무감독 군집(unsupervised clustering)이란 논제와 더불어 훨씬 이전부터 있었을 것으로 예상된다.

코헨 자기조직 신경망에 있어서 강조되어야 할 실제적인 이슈들은 다음과 같다. 첫째, 연결 강도 벡터와 입력 벡터의 정규화이다. 둘째, 코헨 자기조직 신경망은 네트워크 크기(size)가 큰 경우에 잘 작동한다. 네트워크의 크기가 작으면 통계적인 모델의 정확도는 떨어지므로 완전한 결과를 기대할 수 없다.[1]

학습 알고리즘[편집]

코헨 자기조직 신경망에서 학습하는 목표는 네트워크의 다른 부분이 특정 입력 패턴과 유사하게 반응하도록 하는 것이다. 이것은 부분적으로 시각적, 청각적 또는 다른 감각적 정보가 인간의 뇌에서 대뇌피질의 분리된 부분에서 어떻게 처리되는가에 의해 동기가 부여된다. 뉴런의 무게는 작은 무작위 값으로 초기화되거나 두 개의 가장 큰 구성 요소 고유 벡터에 의해 확장된 아공간에서 고르게 샘플링된다. 후자의 대안으로는, 초기 가중치는 이미 코헨 자기조직 신경망 가중치의 근사치를 충분히 제시하기 때문에 학습이 훨씬 더 빠르다. 네트워크는 매핑 중에 예상되는 벡터의 종류를 나타내는 많은 수의 예제 벡터를 공급해야 한다. 그 예들은 보통 반복해서 여러 번 시행된다. 그 훈련은 경쟁력 있는 학습을 활용한다. 훈련 예시를 네트워크에 공급할 때, 모든 중량 벡터에 대한 유클리드 거리가 계산된다. 무게 벡터가 입력과 가장 유사한 뉴런을 최고의 일치 단위(BMU)라고 부른다. 코헨 자기조직 신경망 그리드에서 최고의 일치 단위와 그것에 가까운 뉴런의 무게는 입력 벡터를 향해 조정된다. 변화의 크기는 시간과 최고의 일치 단위로부터 격자 거리에 따라 감소한다. 가중치 벡터 Wv(s)를 가진 뉴런 v의 업데이트 공식은 다음과 같다.

여기서 s는 단계 지수, t는 훈련 샘플에 대한 지수, u는 입력 벡터 D(t)에 대한 BMU의 지수, α(s)는 단조롭게 감소하는 학습 계수, θ(u, v, s)는 스텝 s에서 뉴런 u와 뉴런 v 사이의 거리를 주는 근린 기능이다. 구현에 따라 t는 교육 데이터 세트를 체계적으로 스캔하거나, 데이터 세트(부트랩 샘플링)에서 무작위로 추출하거나, 다른 샘플링 방법을 구현할 수 있다. 근린 기능 θ(u, v, s)은 BMU(뉴론 u)와 뉴런 v 사이의 격자 거리에 따라 달라진다. 가장 간단한 형태로는 BMU에 충분히 가까운 모든 뉴런을 위해 1이고 다른 뉴런을 위해 0이지만 가우스와 멕시칸-햇 기능도 일반적인 선택이다. 기능 형태와 상관없이 근린 기능은 시간이 지날수록 줄어든다. 근린이 넓어지면 처음에는 글로벌 규모로 자체 조직화가 이뤄진다. 근린이 단지 몇 개의 뉴런으로 줄어들었을 때, 그 무게는 지역 추정치로 수렴되고 있다. 어떤 구현에서는 학습 계수 α와 근린 함수 Ⅱ가 s가 증가함에 따라 꾸준히 감소하고, 다른 구현에서는(특히 T가 교육 데이터 세트를 스캔하는 경우) T 단계마다 한 번씩 단계적 방식으로 감소한다. 이 프로세스는 각 입력 벡터에 대해 사이클 λ의 숫자에 대해 반복된다. 네트워크가 출력 노드를 입력 데이터 세트의 그룹 또는 패턴과 연결하게 된다. 이러한 패턴의 이름을 지정할 수 있는 경우, 훈련된 네트의 관련 노드에 이름을 첨부할 수 있다. 매핑하는 동안, 가중치 벡터가 입력 벡터에 가장 가까운 하나의 승리 뉴런이 있을 것이다. 이는 입력 벡터와 가중치 벡터 사이의 유클리드 거리를 계산하여 간단히 결정할 수 있다. 입력 데이터를 벡터로 나타내는 것이 이 글에서 강조되어 왔지만, 디지털로 나타낼 수 있고, 적절한 거리 측정치가 있고, 훈련에 필요한 조작이 가능한 모든 종류의 물체를 자기 조직 지도를 만드는 데 사용할 수 있다. 여기에는 행렬, 연속 함수 또는 기타 자체 구성 지도가 포함된다.[2]

- 초기화

좋은 초기 근사치를 선택하는 것은 신경망을 배우는 모든 반복적인 방법에서 잘 알려진 문제다. 코호넨은 코헨 자기조직 신경망 웨이트의 무작위 개시를 사용했다. 최근 첫 번째 주성분의 공간에서 초기 지도 가중치를 선택하는 주성분 초기화가 인기를 끌고 있는 것은 정확한 결과 재현성 때문이다. 1차원 코헨 자기조직 신경망(주요 곡선의 모델)에 대한 주성분 초기화에 대한 무작위 개시 접근방식의 신중한 비교는 주성분 코헨 자기조직 신경망 초기화의 장점이 보편적이지 않다는 것을 보여 주었다. 최상의 초기화 방법은 특정 데이터 집합의 기하학적 구조에 따라 달라진다. 데이터 집합에 근접한 주성분 곡선이 첫 번째 주성분(수직선 집합)에 불균형하고 선형적으로 투영될 수 있는 경우 주성분 초기화가 바람직하다. 그러나 비선형 데이터 집합의 경우 무작위 시작이 더 잘 수행된다.[2]

- 변수

다음은 필요한 변수들의 모음이다. 굵은 글씨는 벡터를 나타낸다.[2]

- 는 현재의 반복이다.

- 는 반복 한계이다.

- 는 입력 데이터 세트 에 있는 입력 데이터 벡터의 인덱스이다.

- 은 표적 입력 데이터 벡터다.

- 는 지도에 있는 노드의 색인이다.

- 는 노드 의 현재 중량 벡터이다.

- 는 지도에서 가장 일치하는 단위(BMU)의 색인이다.

- 는 BMU와의 거리로 인한 구속으로 보통 근린함수라고 한다.

- 는 반복 진행으로 인한 학습 억제 장치이다.

- 알고리즘

- 지도에서 노드 중량 벡터를 랜덤화

- 임의로 입력 벡터 를 선택

- 지도에서 각 노드 트래버스

- 유클리드 거리 공식을 사용하여 입력 벡터와 지도 노드의 중량 벡터 사이의 유사성 찾기

- 가장 작은 거리를 생성하는 노드 추적

- BMU(BMU 자체를 포함) 근방에 있는 노드의 중량 벡터를 입력 벡터에 더 가깝게 당겨 업데이트

- 를 증가시키고 동안 2단계부터 반복한다.

- 변형 알고리즘

- 지도 노드의 무게 벡터 랜덤화

- 입력 데이터 세트의 각 입력 벡터 이동

- 지도에서 각 노드 트래버스

- 유클리드 거리 공식을 사용하여 입력 벡터와 지도 노드의 중량 벡터의 유사성을 찾는다.

- 가장 작은 거리를 생산하는 노드 추적

- BMU(BMU 자체를 포함) 주변의 노드를 입력 벡터에 더 가깝게 당겨 업데이트

- 지도에서 각 노드 트래버스

- 를 증가시키고 단계에서 반복한다.

구현[편집]

아이리스[편집]

- 피셔의 아이리스 플라워 데이터

각 노드가 중량 벡터를 포함하고 배열에서 그것의 위치를 알고 있는 노드의 배열을 고려한다. 각 중량 벡터는 노드의 입력 벡터와 같은 차원이다. 가중치는 처음에 랜덤 값으로 설정할 수 있다. 이제 지도에 넣을 입력 값이 필요하다. 색은 빨강, 초록, 파랑으로 나타낼 수 있다. 따라서 기초에 의해 생성된 상공의 자유 벡터 공간의 단위 큐브에서 벡터로 색상을 나타낼 것이다.

- R = <255, 0, 0>

- G = <0, 255, 0>

- B = <0, 0, 255>

표시된 다이어그램과 교육 결과를 데이터 세트와 비교하면 다음과 같다.

- 3색 = [255, 0, 0], [0, 255, 0], [0, 0, 255]

- 8색 = [0, 0, 0], [255, 0, 0], [0, 255, 0], [0, 0, 255], [255, 255, 0], [0, 255, 255], [255, 0, 255], [255, 255, 255]

그리고 원본 이미지와 그 둘 사이의 현저한 유사성에 주목한다. 마찬가지로 피셔스 아이리스의 학습률 0.1로 250회 반복을 위해 40×40 그리드의 뉴런을 훈련시킨 후, 지도는 이미 종간의 주요 차이를 감지할 수 있다.[2]

R[편집]

훈련[편집]

R의 코노헨 패키지는 코헨 자기조직 신경망의 생성과 시각화를 용이하게 하는 문서화된 패키지다. 시작하기 위해서는 소수의 주요 기능에 대한 지식이 필요하다. R의 일반 프로세스는 다음과 같다.

# # # # _[ ] # # # ___ # # # _ # # ___ _

시각화[편집]

코노헨 플롯 함수는 생성된 코헨 자기조직 신경망의 품질을 시각화하고 데이터 집합의 변수 사이의 관계를 탐색하는 데 사용된다. 사용할 수 있는 플롯 유형에는 여러 가지가 있다. 각각의 사용법을 이해하는 것은 코헨 자기조직 신경망을 탐색하고 당신의 데이터에서 관계를 발견하기 위한 열쇠이다.

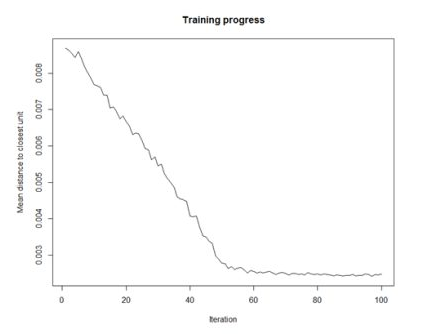

- 교육 진행률

코헨 자기조직 신경망 훈련 반복이 진행됨에 따라, 각 노드의 무게에서 해당 노드로 대표되는 샘플까지의 거리가 감소한다. 이상적으로는 이 거리가 최소 고원에 도달해야 한다. 이 플롯 옵션은 시간의 경과에 따른 진행 상황을 보여준다. 곡선이 지속적으로 감소한다면 더 많은 반복이 필요하다.

|

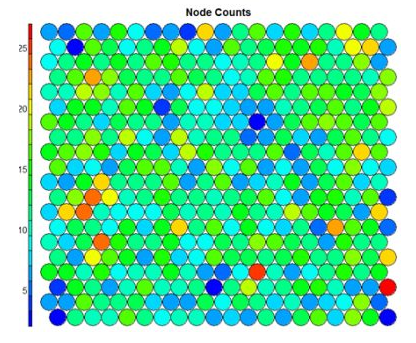

- 노드 수

코호넨 패키지는 지도상의 각 노드에 매핑된 샘플의 개수를 시각화할 수 있게 해준다. 이 메트릭은 지도 품질을 측정하는 데 사용될 수 있다. 이상적으로는 표본 분포가 비교적 균일하다. 일부 지도 영역의 값이 크면 더 큰 지도가 인공적인 것일 수 있다. 빈 노드는 지도 크기가 표본 수에 비해 너무 크다는 것을 나타낸다. 지도 크기를 선택할 때는 노드당 최소 5-10개의 샘플을 목표로 한다.

|

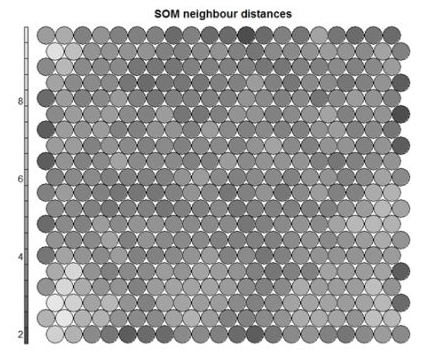

- 인접 거리

흔히 "U-Matrix"라고 불리는 이 시각화는 각 노드와 인접 노드 사이의 거리에 있다. 일반적으로 회색조 팔레트로 볼 때 인접 거리가 낮은 영역은 유사한 노드 그룹을 나타낸다. 거리가 먼 영역은 노드가 훨씬 더 다르며 노드 클러스터 간의 자연적인 경계를 나타낸다. U-Matrix를 사용하여 코헨 자기조직 신경망 맵 내에서 클러스터를 식별할 수 있다.

|

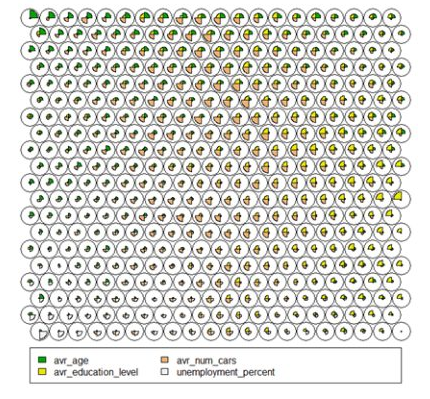

- 코드/체중 벡터

소모드 중량 벡터 또는 "코드"는 코헨 자기조직 신경망 생성에 사용된 원래 변수의 정규화된 값으로 구성된다. 각 노드의 중량 벡터는 해당 노드에 매핑된 샘플과 대표적이다. 지도 전체에서 무게 벡터를 시각화함으로써 우리는 표본과 변수의 분포에서 패턴을 볼 수 있다. 중량 벡터의 기본 시각화는 "팬 다이어그램"으로, 중량 벡터 내 각 변수의 크기에 대한 개별 팬 표현이 각 노드에 대해 표시된다. 다른 대표자를 사용할 수 있다.

|

- 히트맵

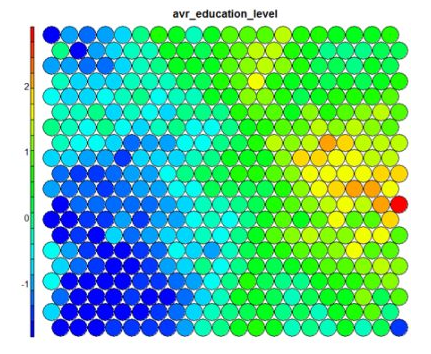

히트맵은 아마도 자체 조직 지도에서 가능한 가장 중요한 시각화일 것이다. 하나의 다이어그램에서 모든 치수를 보려는 위의 중량 공간 뷰를 사용하는 것은 고차원 코헨 자기조직 신경망에 적합하지 않다. 코헨 자기조직 신경망 히트맵을 통해 단일 변수 분포를 지도 전체에 걸쳐 시각화할 수 있다. 일반적으로 코헨 자기조직 신경망 조사 프로세스에는 여러 히트맵을 생성한 다음 이러한 히트맵을 비교하여 맵에서 흥미로운 영역을 식별하는 과정이 포함된다. 개별 샘플 위치가 한 시각화에서 다른 시각화로 이동하는 것이 아니라, 지도는 단순히 다른 변수에 의해 색칠된다는 것을 기억해야 한다. 기본 코호넨 히트맵은 열 지도 유형을 사용한 다음 노드 가중치 집합에서 변수 중 하나를 제공하여 생성된다. 이 경우 우리는 코헨 자기조직 신경망의 평균 교육 수준을 시각화한다.

|

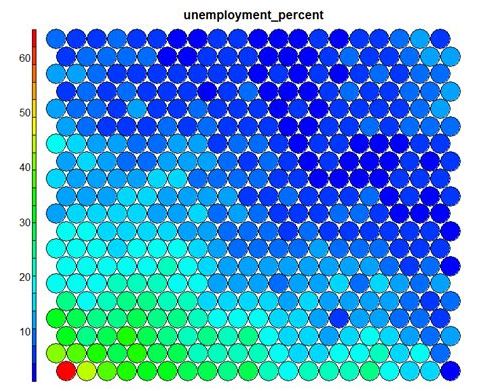

이 기본 시각화는 관심 변수의 정규화된 버전을 나타낸다는 점에 유의해야 한다. 보다 직관적이고 유용한 시각화는 스케일링 전 변수에 대한 것으로, 여기에는 일부 R 속임수가 수반된다. 즉, 집계 기능을 사용하여 원래 교육 세트와 코헨 자기조직 신경망 노드/샘플 매핑에서 변수를 재생성한다. 결과는 훈련 변수의 실제 가치(이 경우 실업률)로 조정된다.

|

위의 히트맵이 곧바로 더블린 주변 지역의 실업률과 교육수준의 역효과를 나타낸다는 점은 주목할 만하다. 나란히 시각화된 추가 히트맵은 다양한 영역과 그 특징에 대한 그림을 구축하는 데 사용될 수 있다.[4]

문제[편집]

- 해석

코헨 자기조직 신경망을 해석하는 두 가지 방법이 있다. 왜냐하면 훈련 단계 가중치는 온 동네의 같은 방향으로 이동하기 때문에 비슷한 아이템이 인접한 뉴런을 흥분시키는 경향이 있다. 따라서 코헨 자기조직 신경망은 유사한 샘플이 서로 가깝게 지도되어 있고 서로 다른 샘플이 떨어져 있는 의미 맵을 형성한다. 이것은 코헨 자기조직 신경망의 U-Matrix(주변 셀의 중량 벡터 사이의 유클리드 거리)로 시각화할 수 있다.

다른 방법은 뉴런 가중치를 입력 공간에 대한 포인터로 생각하는 것이다. 그들은 훈련 표본의 분포에 대한 개별적인 근사치를 형성한다. 더 많은 뉴런은 훈련 샘플 농도가 높고 샘플이 부족한 지역을 가리킨다.

코헨 자기조직 신경망은 주성분 분석(PCA)의 비선형 일반화로 간주될 수 있다. 인공 및 실제 지구물리학적 데이터를 모두 사용해 코헨 자기조직 신경망이 경험직교기능(EOF)이나 주성분 분석 등 기존 형상 추출 방식에 비해 장점이 많은 것으로 나타났다. 원래 코헨 자기조직 신경망은 최적화 문제에 대한 해결책으로 공식화되지 않았다. 그럼에도 불구하고, 코헨 자기조직 신경망의 정의를 수정하고 유사한 결과를 제공하는 최적화 문제를 공식화하려는 시도가 여러 번 있었다.[2]

- 대안

- 생성지형도(Generative Topographical map)는 코헨 자기조직 신경망의 잠재적 대안이다. 생성지형도는 입력 공간부터 지도 공간까지의 매끄럽고 연속적인 매핑을 명시적으로 요구한다는 점에서 위상 보존이다. 그러나, 실용적 의미에서 위상학적 보존의 이 방안은 부족하다.

- TASOM(time adaptive self-organizing map) 네트워크는 기본 코헨 자기조직 신경망의 확장이다. TASOM은 적응형 학습 속도와 주변 기능을 채택한다. 또한 네트워크를 입력 공간의 스케일링, 변환 및 순환에 불변하도록 하는 스케일링 매개 변수를 포함한다. TASOM과 그 변형은 적응형 클러스터링, 다단계 임계값, 입력 공간 근사치 및 능동 등고선 모델링을 포함한 여러 응용 분야에서 사용되어 왔다. 또한, TASOM 네트워크로 구성된 노드를 갖는 바이너리 천연 트리를 닮은 바이너리 트리 TASOM 또는 BTASOM은 그 수준 수와 노드 수가 환경에 적응하는 곳에서 제안되었다.

- 점점 커지는 자기조직지도(GSOM)는 자기조직지도의 변종이다. GSOM은 코헨 자기조직 신경망에서 적절한 지도 크기를 식별하는 문제를 해결하기 위해 개발되었다. 최소 노드 수(보통 4개)로 시작해 휴리스틱을 기반으로 경계에서 새로운 노드를 성장시킨다. 데이터 분석가는 스프레드 팩터라는 값을 사용하여 GSOM의 성장을 제어할 수 있는 능력을 갖췄다.

- 탄성 지도 접근법은 탄성 에너지의 최소화에 대한 아이디어를 스플라인 보간으로부터 얻는다. 학습에서 최소 제곱 근사 오차로 2차 휨과 스트레칭 에너지의 합을 최소화한다.

- 연속 표면의 그리드 노드 간에 각 교육 샘플을 보간하기 위해 정합성 매핑을 사용하는 정합성 접근법이 있다. 이 접근법에서는 일대일 매끄러운 매핑이 가능하다.

- 지향적이고 확장 가능한 지도(OS-Map)는 근린 기능 및 우승자 선정을 일반화한다. 동질 가우스 근린 함수는 행렬 지수 함수로 대체된다. 따라서 지도 공간이나 데이터 공간에 방향을 지정할 수 있다. 코헨 자기조직 신경망에는 고정 척도(=1)가 있어 지도는 관찰 영역을 최적으로 기술한다. 도메인을 두 번 또는 n-폴드로 덮은 지도는 스케일링의 개념을 수반한다. OS-Map은 그 스케일을 지도에 입력된 가장 잘 어울리는 노드 수에 대한 통계적 설명으로 간주한다.[2]

각주[편집]

- ↑ 1.0 1.1 1.2 김대수, 〈코호넨 네트워크〉, 《aistudy》

- ↑ 2.0 2.1 2.2 2.3 2.4 2.5 2.6 Self-organizing map Wikipedia - https://en.wikipedia.org/wiki/Self-organizing_map

- ↑ green, 〈Self-organizing map(SOR)〉, 《人CoDOM》, 2017-07-28

- ↑ shanelynn, 〈Self-Organising Maps for Customer Segmentation using R〉, 《Astra WordPress Theme》

참고 자료[편집]

- Self-organizing map Wikipedia - https://en.wikipedia.org/wiki/Self-organizing_map

- 김대수, 〈코호넨 네트워크〉, 《aistudy》

- shanelynn, 〈Self-Organising Maps for Customer Segmentation using R〉, 《Astra WordPress Theme》

- green, 〈Self-organizing map(SOR)〉, 《人CoDOM》, 2017-07-28

같이 보기[편집]

이 코헨 자기조직 신경망 문서는 인공지능 기술에 관한 글로서 검토가 필요합니다. 위키 문서는 누구든지 자유롭게 편집할 수 있습니다. [편집]을 눌러 문서 내용을 검토·수정해 주세요.

이 코헨 자기조직 신경망 문서는 인공지능 기술에 관한 글로서 검토가 필요합니다. 위키 문서는 누구든지 자유롭게 편집할 수 있습니다. [편집]을 눌러 문서 내용을 검토·수정해 주세요.

해시넷

해시넷