오디오

오디오(audio)는 가청 주파, 저주파(audio frequency)의 약칭으로 일반적으로는 사람이 들을 수 있는 음역 내의 음파 및 그것을 변환한 전기 신호를 다루는 시스템을 가리킨다.

목차

개요

오디오는 음악, 사람의 목소리, 자연음 등 가청 주파수대역 내의 음파(보통 30~16,000 Hz)를 전기에너지로 변환하여 기록(녹음), 또는 기록된 신호를 음파 에너지로 변환하여 공간에 방사·재생하는 시스템이다. 이에는 음파를 전기신호로 변환하는 마이크로폰, 공중에 발사된 전파를 선택하여 그 속에 포함된 음성신호를 추출하는 튜너, 레코드의 소리홈의 기계진동을 전기신호로 변환하는 레코드 플레이어, 전기신호를 자기신호로 변환하여 기록하고 기록된 자기 에너지를 전기 신호로 변환하는 테이프리코더, 미소한 전기 신호를 증폭하는 앰플리파이어, 앰프로 증폭된 전기 신호를 기계 진동으로 변환하여 음파로서 공간에 복사하는 스피커 등이 포함된다. 이들 변환기 ·증폭기의 적당한 배합과 각 부분의 질적 향상에 의해 실용상 또는 예술적으로 가장 좋은 상태로 음악, 사람의 음성, 자연음을 재생하는 것을 최대의 목적으로 삼는다. 오디오와 대조적으로 고주파 또는 무선신호를 다루는 라디오, 가시신호(可視信號) 및 영상신호(映像信號)를 다루는 비디오(video) 등의 분야도 있다.[1]

진화

1992년 돌비래버러토리스(Dolby Laboratories)에서는 현재 5.1채널로 알려져 있는 돌비 스테레오디지털(Dolby Stereo Digital) 기술을 발표했다. 돌비 스트레오디지털은 기존 매트릭스 방식의 부·복호화가 아닌, 독립적인 채널을 제공하는 것으로 전방에 좌·우·중앙 3개 채널과, 후방에 좌우 서라운드 채널, 저음역 강조를 위한 LFE(Low Frequency Enhancement) 채널로 구성되어 있다. LFE(Sub-woofer) 채널은 주파수 대역을 120Hz 아래로 제한한 채널로, 잔향이 있는 환경에서 인간이 음원의 방향을 인지하는 범위를 벗어나는 영역이므로, 스피커 배치가 자유롭다. THX에서는 10.2채널 서라운드 기술을 개발하였다. 10.2채널은 기존 5.1채널 전면부에 4개 채널, 후면에 1개 채널을 추가하고, 우퍼 채널을 1개 추가한 구조이다. 10.2 채널부터 전면부에 많은 채널을 추가한 이유는 사람의 음상에 대한 공간 지각이 후면보다는 전면이 더 정확하기 때문이다. 전면에 추가한 2개 채널은 수평면이 아닌 청취자와 수직면에서 45도 각도를 가지는 위치에 배치하여 음장의 깊이를 더 증가시켰다. UHDTV 방송 서비스에서 오디오 신호는 일반적으로 10개 채널 이상의 다채널 오디오로 정의하고 있으며, 일본방송협회(NHK)에서는 극장과 같은 넓은 공간에서는 스피커를 설치하여 22.2채널의 오디오를 제공할 수 있도록 하고 있다. 일본방송협회의 22.2채널 오디오 재생 시스템의 구성은 상위(Upper) 레벨에는 9개, 중간(Middle) 레벨에는 10개, 하위(Lower) 레벨에는 5개의 스피커를 배치하였고, 서브우퍼 효과음을 강화하기 위해 2개의 서브우퍼 채널을 사용한다. 5.1채널 시스템을 포함한 기존의 멀티채널 오디오 스피커 배치가 청취자와 스피커 사이의 거리를 동일하게 하기 위해 원형으로 배치하는 것에 비해 극장 환경을 고려하여 청취 공간을 사각형으로 배치한 것이 특징이다.

앰비소닉(Ambisonic)은 음장에 대한 정보를 얻는 방법과 일정한 방식의 스피커로 재생하는 시스템으로, 실제적인 입체음향 이미지를 만들어 가는 시스템이다. 1920년대 말 영국의 천재 기술자 앨런 블럼라인(Alan Dower Blumlein)이 개발한 기술은 8자 지향성을 가지는 마이크 쌍을 가능한 한 가깝게 위치시켜 전방에서 각각 45도 각도를 이루게 하고 있다. 이 방식은 스테레오 이미지는 훌륭하지만 몇 가지 문제가 있었다. 8자 지향성이라 뒤에서 울려오는 소리까지 담기고, 스테레오 스피커로 재생할 때 녹음된 후방의 소리가 전방에 재생된다. 이러한 소리는 너무 많은 잔향을 남긴다. 블럼라인 기술의 단순하면서도 정확한 면에 매료되어 있던 순수 레코딩 엔지니어들은 8자 지향성 마이크를 클로버형 지향성 마이크로 교체하여, 이들 사이의 각도를 바꾸어 원하는 사운드 스테이지만 포함하게 만들었다. 또한 클로버형 지향성 마이크의 뒤에서 오는 소리에 대해 응답을 줄여 후방에서 오는 잔향 신호가 전방 사운드 스테이지에 매핑되는 현상을 줄였다. 그 결과 오디오 이미지의 정확도는 약간 떨어져도 결과는 양호한 편이 되었다. 하지만 앰비소닉은 블럼라인의 본래 생각으로 되돌아가 그 위에 새로운 방법을 더했다. 오직 무지향 마이크를 8자 지향성 마이크 쌍에 추가해 가능한 모든 음장 정보를 얻었다. 물론 이것은 모든 마이크를 완전히 일치하게 배치했다는 가정 아래 이루어진다. 즉 모든 마이크가 음장 내에서 음향학적으로 같은 장소에 위치하게 한다는 의미다. 이것은 상하 정보를 위해 8자 지향성 마이크를 하나 더 추가하는 경우 더욱 어려워진다. 이 문제는 음장 마이크로 해결이 가능하다. 이 마이크는 입력 신호를 얻기 위해 가상의 구 표면에 4개의 작은 캡슐을 배치하면서 물리적 마이크 배치의 문제점을 해결하였다. 앰비소닉스의 기본 개념은 공간상의 한 점에 입사하는 특정 방향과 모든 방향의 입사 신호를 획득하는 것이다. 그러나 마이크를 필요한 만큼 소형으로 만들 수 없기 때문에 물리적으로 불가능하다. 하지만 입력 음을 구의 표현에서 획득하여 이를 수학적인 과정을 거쳐서 무한히 작은 점으로 입사하는 신호를 계산할 수 있다.

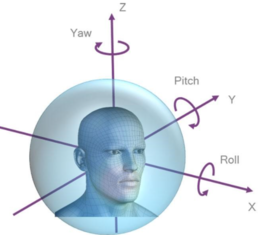

음장 마이크는 효과적으로 4개의 마이크를 위치시킨 것으로, 4개 마이크의 출력 신호를 A포맷(A-format) 신호라 한다. 이 신호를 적절한 처리 과정을 거쳐서 W, X, Y, Z의 B포맷(B-format) 신호로 변경한다. 여기서 전 방향 마이크의 출력이 W신호이고, 8자 지향성 마이크 3개의 출력이 X, Y, Z다. X는 전후, Y는 좌우, Z는 상하를 의미한다. 이 4개의 신호는 마이크에 도달하는 음향학적 신호의 진폭과 방향에 대한 모든 정보를 제공하며, 이 4개의 신호를 모두 합하여 B포맷이라고 한다. 음장 마이크를 이용하면 모든 방향에서 도달하는 음에 대해 거의 평탄한 주파수 특성을 가지는 B포맷 신호를 생성할 수 있다. 1970년대 앰비소닉스 기술은 상업적으로 실패했지만 여전히 거론되고 있다. 이는 몇몇 소수 마니아들 사이에서 기술적으로 우수하다는 평가를 받기 때문이다. 사실 앰비소닉스가 실패한 이유 중 하나는 쿼드러포닉(Quadraphonic)이 실패한 상황에서 시장에 도입되었기 때문이다. 또한 앰비소닉은 스피커를 다양하게 배치할 수 있지만, 그 결과 디코더 시스템이 복잡해 상용화를 어렵게 했다. WFS(Wave Field Synthesis)는 주 음원에서 발생한 음파를 음파의 전면(wave front)에 배치된 여러 음원을 이용하여 재구성할 수 있다는 호이겐스(Christiaan Huygens)의 원리를 바탕으로 스피커를 여러 개 배치한 스피커 어레이를 이용하여 음장을 재현해 주는 기술이다. WFS는 기존 스테레오나 5.1채널 멀티채널 시스템보다 더 넓은 공간에서 실제 음장의 속성을 재현해 주어 청취 공간을 넓혀주는 특성을 가졌다. WFS의 가장 큰 장점은 원리가 간단하고, 재생 시스템을 구성하는 스피커 어레이 신호를 매우 쉽게 계산할 수 있다는 점이다. 스피커 입력 신호는 약간의 필터링 작업과 크기 및 시간 지연을 조절하여 얻을 수 있다. WFS를 이용하면 스피커 어레이 뒤쪽에 위치한 가상의 점 음원을 합성하거나, 멀리서 전파되는 평면파를 합성할 수도 있다. 심지어 어레이 앞에 위치한 가상 점 음원을 합성할 수도 있다. 따라서 WFS는 비교적 복잡한 가상 음장을 합성할 수 있는 기술로, 일정한 영역의 청취 공간에서 일관성 있게 가상 음장을 경험할 수 있게 해준다.

현재 WFS 기술은 청취자 중심으로 둘러싸는 형태로 다수 개의 스피커를 구성해야 한다는 점과 WFS 신호의 생성을 위해 객체별로 음원을 확보해야 한다는 점에서 상대적으로 많은 관심을 받지 못하고 있다. 이에 따라 WFS 연구 방향은 대형 청취 공간에서 활용하는 시스템으로 제한하고 있으며, 시스템을 위한 음원의 획득에서 재생까지 모든 것을 처음부터 일괄적으로 처리하겠다는 것을 의미한다. 다시 말해 가정과 같은 상대적으로 협소한 환경에서 WFS를 활용하는 연구가 거의 진행되지 않고 있다. 하지만 전면과 후면의 스피커 어레이만을 이용하는 WFS 기술은 가정 환경에서 넓은 청취 영역을 제공하는 음장 재현 기술로 주목받고 있다. 특히 UHDTV 등 고화질 대형 디스플레이를 가지는 초현실감 방송 환경에서 고음질 음향을 제공하기 위한 새로운 음장 재현 방식으로 적합한 기술이다.[2]

기술

주파수 변환

CD 포맷은 높은 비트율을 가지고 있다. 그럼에도 불구하고 중음 대역(2~5kHz)에서는 여전히 원음에 가깝지 못하다. 이를 보다 낮은 비트율에서 원음에 가깝게 소리를 재생하려면 좀더 신중한 코딩 방식이 필요하다. PCM, CD 포맷처럼 시간 샘플 영역에서 양자화를 수행하는 것이 아니라, 주파수 샘플 영역에서 양자화를 수행하는 방법이 있다. 이를 보다 쉽게 이해하기 위해서 시간 영역 신호가 주파수 영역으로 표현되었을 때의 주요 특징은 다음과 같다. 시간 영역 신호는 주파수 영역으로 표현할 때, 매우 간단하게 표현할 수 있는 경우가 발생한다. 예를 들어 주기적인 신호를 갖는 사인(sine)파와 같은 신호를 주파수 영역으로 표현할 때, 두 개의 샘플로 표현이 가능하다. 이는 주기 성분과 진폭의 크기만 안다면 원 시간 영역 사인 신호를 복원할 수 있기 때문이다. 이처럼 시간 영역에서는 많은 샘플로 표현되는 것도 주파수 영역에서는 대표적인 주파수 값의 성분으로 표현이 가능하다. 따라서 이 경우 시간 영역 디지털 오디오 코더를 사용한다면 상당히 많은 수의 샘플에 많은 양의 비트를 할당해야 한다. 그러나 주파수 영역에서는 단지 두 개의 샘플만 표현하면 되기 때문에 적은 양의 비트로도 동일한 신호를 표현할 수 있다. 여기서 알아야 할 사항은 시간 영역 신호를 주파수 영역 신호로 변환하는 과정과 그 역변환 과정이 코딩 과정에 필요하다는 것으로 복잡도의 증가를 야기할 수 있다. 그러나 현대에 들어 하드웨어의 급격한 성장을 기반으로 보다 높은 복잡도의 오디오 코더도 수용할 수 있는 환경에서 낮은 비트율로 높은 음질을 낼 수 있는 코더들이 많이 등장하였다.

이제 주파수 영역으로 신호를 변환한다는 것의 의미를 대략적으로 이해했으면, 시간 영역 신호를 좀더 현명한 코딩 방법으로 주파수 영역 신호로 변환해야 한다. 주파수 영역의 신호에 동적으로 비트를 할당할 수 있는 코더를 생각해 보면 보다 효율적인 오디오 코더를 구성할 수 있을 것이다. 예를 들어 인지하기 쉬운 저주파 대역에는 많은 비트를 할당하고, 고주파 대역에는 적은 비트를 할당하는 행위가 가장 기본적인 동적 비트 할당 전략이 될 수 있을 것이다. 또한 앞서 설명한 것과 같이 시간 영역 신호가 사인파와 같은 주기 신호라면 주파수 영역에서 표현하는 것은 매우 쉬운 일이다. 그러나 일반적으로 사인파와 같이 완벽한 주기를 가지고 나타나는 사운드는 찾기가 힘들다. 대부분의 소리들이 주기적이기는 하지만, 시간에 따라 주기 및 진폭이 변화하는 다양한 주기 특성도 있다. 그렇다 하더라도 주기적인 특징을 가지면 주파수 영역에서는 특정 구간에 밀집되어 신호가 나타난다. 따라서 이러한 구간에만 비트를 잘 할당한다면 주기적인 신호의 표현에서 중복성(redundancy)을 최소화할 수 있을 것이다.

부호화 기술

부호화 기술은 디지털로 변환된 오디오 신호를 압축하여 표현하고 복원하는 것을 의미한다. 오디오 신호는 시간축과 크기 또는 에너지 축으로 구성되는 2차원 평면상에서 표현될 수 있다. 이렇게 표현되는 오디오 신호는 이를 생성하는 음원(Sound source)의 특성에 따라 통계학적으로 일정한 성질(주기, 하모닉스 등)을 가질 수도 있으며, 백색잡음(White noise)과 같이 전 주파수 대역에 걸쳐서 무작위로 존재하는 신호로 표현될 수도 있다. 그러나 통상적인 오디오 신호는 다수의 음원들이 혼합되어 구성되므로, 전술한 통계적 특성과 잡음 특성이 모두 있다고 가정하는 것이 적절하다. 음성 신호는 음원을 사람의 발성기관으로 한정하고 있기 때문에 이를 적절히 표현할 수 있는 소수의 파라미터만으로도 부호화가 가능하지만, 오디오 신호에는 적용하기가 어렵다. 최근 음원 분석 기법 등을 통해 오디오 신호에 대한 파라미터 부호화가 시도되고 있기는 하지만, 방송 환경과 같이 음질이 가장 중요한 성능 척도가 되는 응용 분야에 적용하기에는 무리가 있다. 이 절에서는 오디오 부호화 기술들에 한정해 소개하며, 이는 크게 손실 오디오 부호화(Lossy Audio Coding)와 무손실 오디오 부호화(Lossless Coding) 기술로 분류할 수 있다. 먼저 무손실 오디오 부호화 기술은 부호화하기 전의 원음 신호(Original Signal)와 부호화(Encoding) 및 복호화(Decoding) 과정을 거친 복원 신호(Reconstruction Signal)가 파형상 완전히 동일한 결과를 나타내는 기술을 의미한다. 손실 오디오 부호화 기술은 원음 신호와 복원 신호의 신호 파형 자체가 달라지는 기술을 의미한다. 손실 오디오 부호화 기술 중 원음 신호와 복원 신호의 파형이 변하지만 지각적으로는 구별하기 힘들게 압축하는 기법을 지각 오디오 부호화(Perceptual Audio Coding) 기술이라 부른다. 무손실 오디오 부호화 기술은 원음의 음질을 완벽하게 유지할 수 있으나, 압축 효율이 높지 않다. 지각 오디오 부호화 기술은 압축 효율이 높으면서도(10~20배) 음질을 지각적인 손실 없이 유지할 수 있다.[3]

무손실 부호화

무손실 부호화 과정에 입력으로 들어오는 신호는 1024개의 양자화된 스펙트럼 계수이다. 계수들이 들어오면 먼저 무손실 동적 영역 압축이 수행된다. 섹션 분할, 그룹화와 인터리빙, 스케일팩터 등의 방식이 사용된다. 신호의 크기가 1을 넘는 네 개의 계수까지는 부호 비트를 제외한 나머지를 허프만 부호화하게 된다. 허프만 부호화는 n개의 양자화된 스펙트럼 계수를 묶어 12개의 코드북 중에서 선택된 허프만 코드로 부호화를 수행하는 방식이다. 허프만 부호 테이블을 초과하는 크기를 갖는 계수들은 초과하는 크기만큼 정수로 부호화된다.[4]

공간 오디오 부호화

공간 오디오 부호화(SAC:Spatial Audio Coding)는 멀티채널 또는 다객체 오디오 신호를 최소한의 채널로 다운믹스된 오디오 신호와 공간단서들로 이루어지는 부가 정보로 분할하여 압축하는 오디오 부호화 방식이다. 자유공간상에서 단일 음원에서 발생된 음파는 두 귀의 크기 차이와 도달 시간 차이를 가지며 도달하게 된다. 청취자는 이런 정보를 통해 음원의 위치를 파악하므로, 이를 양이효과(Binaural Effect)라고 부른다. 이때 두 귀 사이의 음향 신호의 크기 차이를 ILD(Interaural Level Difference), 도달 시간 차이를 ITD(Interaural Time Difference)라고 부르고, 두 귀에 도착한 신호 간의 상관도를 IC(Interaural Correlation)라고 부르며, 이들은 공간단서 파라미터(Spatial Cue Parameter)라고 통칭한다. 공간 오디오 부호화를 멀티채널 신호를 압축하는 데 이용할 때, 스피커에서 두 귀까지의 음향학적 전달함수가 일반적인 환경에서는 알려져 있지 않기 때문에 공간단서들은 재생 환경에 따라서 제한적으로 사용되어야 한다. 그러나 원음과 합성음의 재생 환경이 유사하다고 가정하면 음향학적 전달함수에 의한 영향을 무시할 수 있다. 따라서 스피커로부터 재생되는 멀티채널 신호들에 대한 채널 간의 신호 크기 차이(ICLD:Inter-Channel Level Difference), 채널 간의 시간 차이(ICTD:Inter-Channel Time Difference), 채널 간의 상관도(ICC:Inter-Channel Coherence)는 가상적으로 ILD, ITD, IC와 동일하다고 가정할 수 있으므로, 멀티채널 공간 오디오 부호화에서는 이들을 공간단서 파라미터로 이용한다. 즉 ICLD와 ICTD는 멀티채널 스피커 환경에서 음원의 재현 위치를 결정하며, ICC는 음원의 재현 폭을 결정한다.

음향 신호를 시간·주파수 변환을 통해 얻어진 시간·주파수 평면상에 표현하면, 특정 위치에서 고정된 음원에서 발생하는 모든 음향 신호 성분들은 귀에서 일정한 ILD와 ITD 값을 가지므로, 각 음향 신호 성분들은 자신만의 영역을 차지하게 된다. 물론 특정 시간·주파수 격자에 두 개 이상의 음원들이 존재하거나, 여러 음원들이 겹쳐지는 경우도 발생한다. 그러나 사람의 귀는 특정 시간·주파수 격자에서 두 개 이상의 음향 성분이 존재할 때 상대적으로 에너지가 큰 음원으로 인지하는 특성이 있으므로, 겹치는 영역에 대해서는 에너지가 큰 신호의 영역으로 가정할 수 있다. 팔러는 응용 분야에 따라 두 가지 방식의 BCC 시스템을 제안했다. 첫째는 원격회의와 같이 오디오 객체 간의 상관도가 적은 다객체 오디오 신호를 시간주파수 격자에 대한 인댁스를 공간단서 파라미터로 표현하고, 복호화기에서 자유로이 합성하는 플렉시블 렌더링 방식이다. 둘째는 멀티채널 오디오 신호와 같이 채널 간 상관도가 높은 멀티채널 오디오 신호에 대한 공간단서 파라미터들을 이용하여 멀티채널 신호를 압축하는 내츄럴 렌더링(Natural Rendering) 방식이다. 이러한 플렉시블 렌더링 방식의 BCC 개념은 MPEG 서라운드란 이름으로 멀티채널 오디오 신호를 압축하기 위한 기술로 표준화되었다. 또한 내츄럴 렌더링 방식은 SAOC(Spatial Audio Object Coding)란 이름으로 다객체 오디오 신호를 압축하기 위한 기술로 표준화되었다.[5]

3차원 오디오 획득 기술

더미헤드

더미헤드는 바이노럴 음향을 녹음할 때 쓰는 마이크이다. 3차원 오디오 획득을 위해 실제 사람의 귀에 마이크를 장착하는 것도 가능하지만, 고성능의 마이크를 사람의 귀에 장착하기가 힘들고 잡음 및 움직임의 영향 때문에 사람의 형태를 한 더미헤드에 마이크를 장착하여 3차원 오디오 신호를 획득한다. 더미헤드를 이용하여 획득한 신호를 바이노럴 신호라고 하는데, 헤드폰을 통해 청취할 경우 입체감을 느낄 수 있다. 더미헤드는 머리부분만을 마네킹으로 모사한 것이고, 더미헤드에 몸통까지 포함한 것을 HATS(Head And Torso Simulator)라고 한다. 현재 여러 기업에서 HATS와 더미헤드를 제작하여 판매하고 있다.[6]

구체형 더미헤드

구체형 더미헤드는 기존 사람의 머리 형태를 갖는 기존의 더미헤드를 구체형으로 간략화한 것이다. 더미헤드는 실제 사람의 머리 형태를 가지기 때문에 사람의 청각 특성과 유사하지만, 형태가 크고 보기에도 편하지 않기 때문에, 실제 라이브 환경에서 사용되기에는 어려운 점이 있다. 따라서 사람의 머리 형태를 구체형으로 간략화한 구체형 더미헤드가 많이 이용되고 있다. 구체를 이용하여 획득한 3차원 오디오 신호는 스피커를 통해 재생하는 경우, 더미헤드 획득 신호에서 발생하는 더블 이퀄리제이션(double equalization)이 없고, 형태의 단순성 때문에 3차원 오디오 획득에 많이 이용되고 있다. 한국전자통신연구원에서는 구체 위에 다수의 마이크를 장착하여 3차원 오디오 신호를 획득하고 재생하는 시스템을 개발했다. 한국전자통신연구원의 구체 마이크는 5개의 마이크를 구체 위에 장착하여 3차원 오디오 신호를 획득하고 후처리를 통해 헤드폰, 스테레오, 스테레오 다이폴, 4채널, 5채널 등의 환경에서 재생 가능한 3차원 오디오 신호를 생성한다.[6]

앰비소닉

앰비소닉은 음장에 대한 정보를 획득하는 방법과 일정한 방식의 스피커를 통해 재생하는 시스템으로, 실제적인 3차원 오디오 이미지를 생성하는 시스템이다. 1920년대 말 앨런 블럼라인이 개발한 기술은 8자 지향성을 갖는 마이크 쌍을 가능한 가깝게 위치시키고, 각각 전방에서 45도 각도를 향하게 하는 방식이었다. 이 방식은 훌륭한 스테레오 이미지를 제공하지만 8자 지향성 때문에 후방에서 오는 소리 또한 픽업되고, 스피커 쌍을 통해 재생될 때 이 소리가 접혀 전방에 매핑되어 과도한 잔향이 있는 것처럼 들리게 된다. 블럼라인 기술의 단순성과 정확성을 좋아하는 순수한 레코딩 엔지니어들은 이러한 문제점을 해결하기 위해 8자 지향성을 갖는 마이크를 크로바형 지향성 마이크로 교체하고, 이들 사이의 각도를 변경하여 원하는 사운드 스테이지만을 포함하도록 개선하였다. 또한 크로바형 지향성 마이크의 후방으로부터 도래하는 소리에 대해 응답이 감소하도록 하여 후방으로부터 도래하는 잔향 신호가 전방 사운드 스테이지에 매핑되는 것을 줄였다. 현재는 블럼라인의 원래의 생각으로 다시 돌아가서, 단지 무지향 마이크를 8자 지향성 마이크쌍에 추가함으로써, 가능한 모든 음장 정보를 획득할 수 있도록 개선되었다. 물론 이것은 캡슐을 완전히 일치하게 배치하였다는 것을 가정한다. 즉 모든 3개의 캡슐이 음장 내에서 음향학적으로 동일한 장소에 위치하여야 하지만 현실적으로 불가능하다. 이러한 문제는 사운드필드 마이크에 의해 해결되었는데, 이 마이크는 입력신호를 얻기 위해 가상적인 구의 표면에 4개의 작은 캡슐을 배치함으로써 문제를 해결했다.[6]

3차원 오디오

공간 음향

공간 음향(Spatial Audio) 또는 실감 오디오 기술은 음원이 발생하는 공간과 다른 공간에 위치한 청취자가 음원이 발생한 공간과 같은 방향감, 거리감 및 공간감을 지각할 수 있게 해 주는 기술이다. 공간 음향을 이용하면 청취자는 현장에서 듣는 듯한 생생한 느낌을 받을 수 있다. 청취자에게 3차원적인 공간감과 방향감을 제공하기 위한 공간 음향은 수십 년 동안 연구되어 왔다. 그러나 21세기로 넘어온 지금 디지털 프로세서들이 고속화되고 여러 음향 장치가 획기적으로 발전함에 따라 공간 음향의 구현성이 높아지면서 다시 한 번 큰 관심을 받고 있다. 공간 음향은 활용 분야가 매우 넓다. 가장 대표적인 분야는 영화 산업이다. 서라운드 실감 오디오 효과는 영화의 흥미를 배가시키고, 게임과 가상현실 및 멀티미디어 콘텐츠 분야에서의 실감 오디오 효과는 사용자의 몰입감을 증대시킨다. 자동차의 오디오 및 홈시어터의 실감 오디오는 작은 공간에서도 청취자에게 만족할 만한 음향을 제공할 수 있다. 초고속통신망을 이용한 원격회의, 실감 음향통신, 원격교육 및 방송 등 음향이 필요한 모든 분야에서 공간 음향은 현실감 및 몰입감을 증대하는 매우 중요한 요소 기술이다. 공간 음향도 세부적으로 보면 다양하게 나뉜다. 음원의 위치를 원하는 가상 위치에 정위시키는 음상 정위(Sound Image Localization) 기술, 콘서트홀과 같은 가상의 음원 공간을 생성하는 음장 제어(Sound Field Control) 기술, 메아리나 코러스 같은 효과음(Effect Sound) 생성 기술, 스피커 환경에서 입체음향을 재현하기 위한 간섭(Crosstalk) 제거 기술, 헤드폰 환경에서 머릿속에 맴도는 음상을 머리 밖에 위치시키기 위한 외재화(Externalization) 기술, 2채널의 스피커 환경에서 5.1채널 등 멀티채널 음향효과를 재생할 수 있는 가상 서라운드(Virtual Surround) 기술 등이 있다. 또한 재현 방식에 따라 멀티채널을 이용한 서라운드 방식과 바이노럴(Binaural)을 이용한 2채널 스테레오 방식으로 나눌 수 있다. 공간 음향은 점차 우리 생활 속 깊이 침투하고 있다. 자주 대하는 매체나 모바일 기기들에도 공간 음향을 적용하려는 시도가 계속되고 있다. 공간 음향은 우리가 일상적으로 경험하는 자연스러운 소리를 그대로 재현해 주는 것을 목표로 연구·개발되고 있지만, 아직은 기술적으로 완벽한 해결 방법을 제공하지 못하고 있다. 하지만 머지않아 일상적으로 경험하는 자연스러운 소리를 방송이나 통신 환경에서 제공받을 수 있을 것이다.[7]

채널기반

- 획득 기술

채널기반 음향은 현재 사용되고 있는 다양한 채널 포맷의 음향 신호들은 획득하는 방법으로서, 채널 개수 및 채널의 공간 배치에 따라 여러 개의 마이크로폰을 공간상에 배치하여 청취하기에 적합한 멀티채널 음향신호를 획득하는 방법이다. 주로 사용되는 채널 포맷으로는 모노, 2채널 스테레오, 5.1 채널이 있으며, 영화 및 UHDTV 방송을 위하여 5.1채널보다 많은 채널 개수를 가지는 7.1, 11.1, 10.2, 14.2, 22.2, 30.2채널의 채널 포맷이 등장했다. 스테레오 및 5.1채널의 경우 2개 및 5개의 마이크로폰을 조합하여 단번에 획득하는 방법이 주로 음악 녹음에 사용되고, UHDTV 방송을 위하여 대한민국에서는 10.2채널, 일본에서는 22.2채널 마이크로폰을 개발한 예가 있지만, 대개는 다수의 근접 마이크로폰 및 배경음 마이크로폰으로 녹음한 음향신호들을 프로툴즈(Pro tools), 누엔도(Nuendo) 등과 같은 디지털 오디오 워크스테이션(Digital Audio Workstation)로 믹싱하여 다양한 채널 포맷의 음향 신호를 제작하는 방법이 사용되고 있다.

- 분석 기술

채널기반 음향은 청취자를 중심으로 전방이나 수평면 혹은 반구의 표면에 배치된 다수의 스피커 재생을 기반으로 하고 있으며, 대개 인접한 스피커들을 이용하여 이득 혹은 위상 패닝 방법으로 팬텀 음원을 렌더링하게 된다. MPEG 오디오 기술에 있어 채널기반 음향의 분석 기술은 이러한 패닝 및 상관 파라메터, 즉 CLD(Channel Level Difference), ICC(Inter-Channel Coherence), CPC(Channel Prediction Coefficient)를 추출함으로써 다운믹싱된 신호로부터 원래의 채널 신호를 재합성할 수 있도록 하며, 이로써 전송되는 채널 수를 줄여 압축하는 방법을 제공한다. 또한 이러한 파라미터들을 조정함으로써 음원의 위치, 볼륨 등 다양한 제어가 가능하도록 한다. 한편 음원 분리 기술을 활용하면 채널기반 음향을 객체기반 음향으로 변환할 수 있으며, 이를 통하여 객체기반 음향의 다양한 이점을 활용할 수 있는데, 아직은 음원 분리 기술의 성능이 이러한 방식으로 활용하기에는 부족한 면이 있다.

- 재현 기술

채널기반 음향은 역사적인 배경이 모노채널의 음향으로부터 공간감을 부여하기 위하여 점차 발전되어 온 방식으로서, 그 태생적인 특징에 의해 이상적인 재생 환경과 스윗스팟에 위치한 청취자에게는 이상적인 공간음향을 표현해 줄 수 있다. 하지만 이상적인 환경에서 벗어나는 경우, 이를 보상해 줄 수 있는 기술은 매우 한정적이라고 할 수 있다. 주로 재생 환경의 변화, 즉 재생 스피커의 개수 및 배치의 변화에 대한 보상과 공간의 음향 특성을 변화시키는 방법이 주로 사용되고 있다. 재생 스피커의 개수나 배치가 변화되는 경우, 원제작자가 의도한 음향의 공간적인 이미지가 왜곡될 수밖에 없으므로 스피커의 배치 상황을 측정하여 각 스피커의 위치가 이상적인 위치에 있는 것처럼 각 채널 시놓의 이미지를 조정해야 하는데, 이를 위해서 각 채널 신호의 이득, 지연 및 주파수 특성을 조정하고, 실재하지 않는 스피커에 대해서는 인접 스피커의 패닝에 의해 가상 스피커를 생성하는 방법을 사용할 수 있다. 이 외에도 공간의 잔향 특성을 변화시키기 위해 실내효과 필터를 사용할 수도 있다. 최근에는 스피커의 개수가 증가하고 스피커의 배치가 3차원 공간으로 확장되는 추세에 따라 기존의 두 채널 사이의 패닝에 의한 음향 렌더링 기술에서 3개 이상의 스피커 사이의 패닝을 사용하는 벡터기반 패닝(VBAP: Vector Based Amplitude Panning)이 활용되고 있으며, 주어진 유효청취 영역에 대해 최적 음향 재생을 보장하기 위해 최소 오차를 가지는 응답을 찾아내는 LMS(Least Mean Square)를 이용한 렌더링 방법도 사용되고 있다.[8]

객체기반

객체기반 오디오는 채널기반의 오디오 기술에 대해 다양한 서비스가 가능하고, 재생환경에 독립적인 실감음향 기술이다. 현재 극장 사운드를 중심으로 객체기반 오디오 기술이 적용된 사운드가 점차 확산되고 있으며 미국, 유럽 등 차세대 방송용 오디오에 객체기반 오디오 기술의 도입을 적극적으로 고려하고 있다. 객체기반 오디오 기술은 콘텐츠의 제작 단계에서 재생 환경을 고려할 필요가 없고, 현장의 음향을 신호와 3차원 공간 정보로 구분하여 음향 공간의 정보를 그대로 표현함으로써 재생 환경에서는 3차원 공간 정보를 활용하여 다양한 3차원 음향 재생 기술을 활용하여 재생할 수 있다. 이러한 객체기반 실감음향 기술 개발을 위해서는 편리한 제작 및 3차원 공간 정보 표현 기술이 필요하며, 청취 환경에서는 객체기반 실감 음향 콘텐츠를 제작자의 의도대로 렌더링할 수 있는 재생 및 제어 기술이 필요하다.[9]

- 획득 기술

객체기반 음향은 각각의 객체에서 나는 소리를 주변 환경의 영향을 받지 않는 독립적이고 순수한 상태로 획득하는 것이 좋다. 또한 객체에서 나는 소리는 방향에 따라 다르게 들릴 수 있으므로 다수의 마이크로폰을 활용하여 소리의 지향성 패턴을 함께 녹음하는 것이 이상적이다. 현실적으로 오디오 객체의 방사 패턴을 녹음하는 것은 매우 번거로운 일이기 때문에 대부분의 객체기반 음향 획득은 근접 마이크로폰만으로 획득되고 있으며, 방사 패턴은 포함하고 있지 않다. 또한 객체기반 음향 신호는 재생할 때 공간의 구조 및 흡음·반사 특성 등 공간의 특성과 음원의 위치 정보에 따라 반사음 및 잔향음 신호가 다르므로 객체기반 음향을 재생 환경에서 렌더링할 때 필요한 공간 정보를 메타데이터로 추가 전송할 필요가 있다. 이외에도 보다 세밀한 공간음향 렌더링을 위해서는 음향 객체의 크기, 모양 및 흡음·반사 특성 정보도 함께 획득하여 전송할 필요가 있다.

- 분석 기술

객체기반 음향은 음향 자체의 분석은 필요하지 않으며 렌더링하기 위한 파라미터를 추출하기 위한 분석이 필요하다. 우선 공간의 구조 모델을 분석하는 것이 필요하며, 공간의 구조를 수학적으로 해석하기 위해서는 곡선으로 구성되어 있는 실체의 공간 정보를 정형의 공간 구조로 최적화 및 단순화해야 한다. 즉 임의 공간의 음향의 전파 특성을 분석하기 위해서는 공간을 이루는 각 면은 완전히 평탄해야 하며, 각 모서리는 직선으로 이루어져야 한다. 또한 각 면은 특유의 흡음반사산란 특성을 가지게 되는데, 이들은 주로 재료를 만드는 업체에서 제공하는 데이터를 활용한다. 음원의 자향성 반사면의 흡음특성, 산란특성 등 객체기반 음량의 렌더링을 위해 필요한 파라미터들은 옥타브밴드 혹은 1/3 옥타브밴드로 나눵서 표현되며 이에 의해 산출되는 반사음 및 잔향 특성은 주파수 종속적인 특성을 갖게 되며 청취자를 중심으로 도래방향을 가지는 반사음의 집합이 된다. 임의 공간에서 주어진 음원의 반사파를 추정하는 방법에는 파동에 의한 방법 및 음선에 의한 방법이 있다. 파동에 의한 방법은 파동방정식을 통하여 음원의 파형이 전파되는 현상을 예측하는 방법으로 매우 복잡하지만 상대적으로 정확한 해답을 얻을 수 있다. 음선에 의한 방법은 음원을 광원으로 각 벽면을 거울로 간주하여 샘플링된 음의 입자가 전파되는 경로를 추정하는 방법이며, 대표적으로 음선 추적(RT; Ray Tracing) 방식과 반사 음원(IS; Image Source) 방식이 있다.

- 재현 기술

객체기반 음향은 모든 음원을 별도로 획드갛고 음원의 위치 정보 및 지향성 특성을 메타데이터로 포함하기 때문에 공간음향의 재현 및 제어에 있어 재현 환경 및 청취자의 움직임에 충실히 대응할 수 있는 가장 이상적인 방법이다. 하지만 이미 분석 단계에서 언급한 것과 같이 반사음 및 잔향음을 추정하기 위하여 음향에 최적화된 공간 모델을 필요로 하며, 이는 실시간 응용서비스에 있어서는 커다란 장애물로 작용한다. 객체기반 음향은 모든 음원 및 공간 모델을 최종 청취하려는 공간음향을 생성하기 위한 재료로 사용하므로, 공간모델이 주어지고 청취자의 위치가 정확히 주어지면 복잡한 음향의 전달함수 추정 및 렌더링에 의해 시공간적으로 가변하는 공간음향을 생성할 수 있다는 장점이 있다. 그러나 한편으로는 공간모델, 음원모델 및 청취자모델이 실제의 물리적인 모델을 근사화한 것으로 실제 응답을 정확히 생성할 수 없는 단점이 있다. 객체기반 음향의 실제 청취 환경은 결국 헤드폰 또는 멀티채널 스피커 재생 환경이며, 이들 청취 시스템의 특성에 따라 성능이 좌우될 수 있으므로 청취 시스템의 특성 보정이 필요하다. 또한 청취모델의 경우, 인간의 두 귀의 물리적 특성의 차이로 인해 개인차가 있으므로 헤드폰 재생을 할 때는 개인의 청취모델을 고려하는 것이 필요하다. 이상적으로는 개인의 머리전달함수(HRTF: Head Related Transfer Function)를 직접 측정하여 안경처럼 개인의 청각 특성을 보정하는 것이 필요하지만, 개인의 머리전달함수를 측정하는 것은 매우 힘든 일이므로 귀의 모양이나 머리 및 몸통의 특성값을 기반으로 모델링하는 방법이 주로 사용되고 있다.[8]

장면기반

장면기반 오디오는 떠오르는 차세대 기술로, 시장에서 상용화를 위해 여러 측면에서 발전을 거듭하고 있다. 장면기반을 지원하는 MPEG-H 3D 오디오는 2015년 10월 국제표준기술로 발표되었다. 그리고 MPEG-H는 ATSC 3.0이 선정한 오디오 코덱 후보 2개 중 하나이다. ATSC 3.0은 미국과 국내를 포함한 여러 국가에서 채택한 차세대 디지털 텔레비전 방송 전송 방식이다. 국내의 모든 방송국은 국내 방송 오디오 포맷에 MPEG-H 3D 오디오를 내장할 예정이다. 특히 국내에서 개최되는 2018 평창동계올림픽은 MPEG-H 3D 오디오의 입체 음향과 인터랙티브 성능을 확인할 기회의 장이 되었다. 또 방송 기기의 상호운용성을 지원하기 위해 디스플레이포트(DisplayPort)와 HDMI 사양에 MPEG-H가 포함되었다. 장면기반 오디오는 방송표준 이외의 영역에서도 채택되기 시작했다. 예를 들어, 유튜브는 360o 비디오에서 공간 오디오 구현을 위해 1차 앰비소닉스(First Order Ambisonics, FOA)를 지원한다. 또 유튜브는 온디맨드(On-Demand) 유튜브 비디오를 위해 공간 오디오를 시작했고, 관련 콘텐츠를 축적하고 있다. 1차 앰비소닉스는 각 기기의 스피커 설정에 대응하면서, 단일 포맷으로 3차원 오디오의 장점을 제공한다. 고차 앰비소닉스(Higher Order Ambisonics, HOA)로 발전하면 더 향상된 공간 정밀도와 오디오 충실도를 실현하게 된다. 고차 앰비소닉스의 장점이 뛰어나기 때문에, 다른 서비스에서 채택되는 건 시간 문제이다. 장면기반 오디오는 위치 음향을 포착하고 재생할 때 많은 이점이 있다. 특히 가상현실에서 머리의 위치를 기반으로 자유자재로 음장 조절이 가능하다.

- 획득 기술

장면기반 음향을 획득하는 것은 각 차수의 앰비소닉 채널의 개수 및 지향성 특성을 가지는 마이크로폰을 하나의 점에 배치하여 녹음하는 것이 필요하지만, 복잡한 지향성을 가지는 마이크로폰을 구현하는 것이 불가능하고, 다수의 마이크로폰을 한 점에 배치시키는 것이 불가능하므로 충분한 개수의 단일지향성 마이크로폰을 구체 표면에 균일 분포로 배치하여 A 포맷의 앰비소닉 신호를 획득한 다음 이들 신호들을 조합하여 이론적인 B 포맷의 앰비소닉 신호를 합성하는 방법을 사용하고 있다. 주로 사용되고 있는 1차 앰비소닉 마이크로폰은 네 개의 마이크로폰을 구체 표면에 균일한 분포로 배치하는 것으로 구현할 수 있다.

- 분석 기술

장면기반 음향은 앰비소닉 음향 기술의 수학적 기반에 의해 각 방향으로부터 도래하는 음원 성분에 대한 분석이 용이하다. 실제로 충분히 잘게 나누어진 주파수 대역에 대해 음원의 도래방향 성분 및 지향성의 안정성 파라미터인 확산 성분을 추출함으로써 각 주파수 대역의 신호 성분을 분리된 음원 성분으로 간주하여 렌더링 및 제어하는 것이 가능하다. 장면기반 음향 분석 기술의 예로 핀란드 알토대학교의 빌레 폴키(Ville Polkey) 교수가 고안한 DirAC(Directional Audio Coding) 기술과 호주 울런공대하교의 크리스찬 리츠 교수팀이 고안한 S3AC(Spatially Squeezed Surround Audio Coding) 기술이 있다. 이 기술은 이론적으로 채널기반 음향에도 활용할 수 있으며, 채널 다운믹스 및 업믹스에 의한 전송 채널 감축에 활용되며, 각 방향의 음원에 대해 독립적인 제어가 가능하므로 음향장면 회전, 압축, 음향 확대, 공간 필터링 등 다양한 기능으로 활용될 수 있다.

- 재현 기술

장면기반 음향은 객체기반 음향에 비해서는 다소 공간음향 성능이 떨어진다고 할 수 있지만, 수학적으로 해석 가능하고 파라미터화 할 수 있는 특징에 의해 여러 가지의 공간음향 재현 및 제어 방법을 활용할 수 있다. 즉, 각 방향의 음원들을 근사적으로 구분하여 파라미터화 할 수 있으므로 청취자가 고정된 상황에서 머리의 회전에 의한 360 가상현실 체험에 잘 활용될 수 있으며, 상체의 움직임 정도까지는 보정할 수 있는 기술들이 제안되고 있다. 그러나 가까운 음원이 포함되는 경우 청취자의 움직임 보상에 대한 오차가 증가하게 된다. 다수의 HOA 마이크로폰을 사용하여 6DoF 가상현실을 실현하는 방안으로 주어진 공간의 샘플링된 지점에서 앰비소닉 마이크로폰으로 녹음하고, 그 사이의 처우치자 위치에 대하여 주변 장면기반 음향 신호들을 인터폴레이션에 의해 합성하는 기술들이 제안되고 있다.[8]

하이브리드 오디오

하이브리드 오디오는 채널기반 오디오와 객체기반 오디오를 동시에 포함하는 오디오이다. 국제적으로 통용되는 표현은 하이브리드 포맷 오디오라는 표현으로 많이 사용되며, 의미가 좀 다르지만 몰입형 사운드(Immersive Sound)로 불리는 경우도 있다. 오디오 콘텐츠의 교환을 위한 포맷 형식은 전통적으로 채널기반의 오디오 포맷이 주로 사용되고 있으며, 아직까지도 대세를 이루고 있다. 채널기반의 오디오 포맷은 스피커의 개수와 스피커의 배치 방법이 가장 중요하며, 스피커의 개수 및 배치 방법에 따른 콘텐츠 제작이 이루어지고, 동일한 스피커의 개수 및 배치 방법에 따른 청취 환경에서 청취되기를 기대하게 된다. 하지만, 일반적인 가정의 청취 환경에서는 스피커의 개수나 배치를 정해진 규정에 맞추어 설치하는 것이 어렵다. 그러다 보면 제작자의 의도대로 오디오 콘텐츠의 3차원 이미지를 재현하는 것이 어려워지며, 결국 3차원 오디오의 청취를 포기하게 되는 사례가 많다. 이러한 문제를 해결하기 위해 등장한 것이 객체기반의 오디오 포맷이라 할 수 있으며, 현장의 음원 신호와 음원의 위치 정보를 함께 패키징함으로써, 청취 환경의 스피커 배치에 따라 객체 음원들을 제작자의 의도대로 재현할 수 있게 된다. 객체기반의 음원은 명확한 위치가 감지되어야 하는 중요한 객체 음원을 선별하여 객체기반 오디오 포맷으로 제작하며, 그 밖의 위치 정보가 중요하지 않은 사운드들을 채널기반의 오디오 포맷으로 제작하여 함께 패키징하는 것이다. 단말에서는 하이브리드 오디오 콘텐츠를 해석하여 객체기반 음원 신호와 공간 정보를 포함하는 메타데이터를 추출하여 렌더링하게 되고, 이를 채널기반 오디오 신호와 믹싱하여 재생한다.[10]

주요 기업

가우디오랩㈜

가우디오랩㈜은 오디오 테크 스타트업 기업이다. 특히 바이노럴 렌더링 VR 오디오 기술은 뛰어난 경쟁력을 자랑하고 있다. 이 기술은 2014년 MPEG-H 3D 오디오 국제표준에 채택된 것이다. 퀄컴(Qualcomm), 화웨이(Huawei), 프랑스 텔레콤(France Telecom) 등 세계적인 기업들과의 경쟁을 제치고 우수한 기술력을 인정받았다. 바이노럴 렌더링 VR 오디오 기술은 사용자의 위치와 시선에 따라 소리의 방향과 음량이 함께 바뀌는 VR 오디오 기술이다. 가상현실 콘텐츠 분야에 있어 더욱 빛을 발할 것으로 보이고 있다. VR 오디오 기술을 VR 콘텐츠에 도입하면 그 실감이 대폭 향상된다. 예를 들어 VR로 구현된 콘서트 현장, 여행지 등에서 고개를 돌리면 주변 소리의 음량·방향이 달라지는 것과 같은 이치다. 이 오디오 기술은 바닥이나 벽에 반사되는 소리까지 표현해 실제와 혼동될 정도의 효과를 낸다. 음원과 사용자의 위치, VR 콘텐츠 내 인터랙티브 요소를 실시간 판독, 최적화된 음량을 제공하기 때문이다. 또한 하드웨어가 아닌 소프트웨어 기반 기술로, 기존 헤드폰과 이어폰에도 적용할 수 있다는 점이 주목할 만하다. 특별한 장치 없이도 언제, 어디서나 실감나는 음질의 소리를 경험할 수 있다. 입체감 등 성능을 극대화하면서도 낮은 연산량과 최적화 설계로 모바일 기기에 쉽게 탑재할 수 있는 형태의 소프트웨어 기술 스택을 가진 것은 기존의 극장시스템, TV/AVR 등의 하드웨어 기기를 위해 개발됐던 타 기업의 기술‧제품군과는 차별성을 가진다. 이에 VR 콘텐츠 제작자들의 창작의 폭까지 넓히며 그 범위를 확장시켰다. 기존의 콘텐츠 제작 과정에 바로 적용할 수 있고, 다양한 소리 형식을 지원할 수 있기 때문이다. 여기에는 웍스(Works) 기술을 이용해 사운드 엔지니어들이 그들의 작업 환경에서 편리하게 VR 오디오를 적용할 수 있도록 했다. 웍스로 제작된 콘텐츠는 후에 헤드 마운트 디스플레이, 스마트폰 등에 탑재된 Sol VR360 SDK를 이용해 재생되는 형식이다. VR의 완전한 몰입감을 경험할 수 있는 입체음향 기술로 주목받고 있다. 가우디오랩은 2016년 시리즈 A 투자를 통해 헐리우드에 진출하는 목표로 로스앤젤레스에 상륙했다. 이에 헐리우드의 주요 스튜디오들과 VR 컨텐츠 제작에 기여하는 성과를 얻었다. 베니스 영화제 등 주요 영화제에서 수상하는 작품에는 가우디오랩의 오디오 기술이 적용되기도 했다. 가우디오랩은 미국을 중심으로 전 세계 사업 전개를 진행 중이다. 이 외에도 VR을 위한 엔드투엔드(End-to-End) 솔루션, OTT·미디어 스트리밍, 음악 서비스, TV·스마트폰에 들어가는 오디오 차별화 기술, 사운드바, 인공지능 스피커를 위한 기술 등 다양한 기술의 연구 개발을 진행하고 있다.[11]

가우디오랩㈜은 2017년 스페이셜 오디오 기술을 개발했다. 고개를 돌리면 소리의 방향도 달라지는 기술로 시간이 가면 화면이 바뀌면서, 그 화면에 맞게 소리의 방향이나 공간감도 자동으로 바뀐다. 스페이셜 오디오는 소리라는 재료를 활용해 이어폰/헤드폰을 착용한 사용자의 귓속에 새로운 공간을 그려내고 그 공간 안에 사용자가 존재하는 것처럼 느끼게 해 주는 기술이다. 스페이셜 오디오를 구현하는 주요 기술은 소리의 위치를 파악해 바이노럴 렌더링을 통해 양쪽 귀로 전달하는 것이다. 이 기술을 통해 고개를 돌릴 때마다 소리 위치가 더 생생하게 느껴진다. 소리의 위치 파악이 되었다면 공간 상에 정해진 상호작용을 할 수 있다. 이들이 이렇게 생동감 넘치는 소리를 만든 이유는 2015년 창업 당시부터 메타버스에 집중했기 때문이다. 이처럼 다양하고 재미있는 음향 기술을 보유한 가우디오랩은 이제 메타버스에 탑승해 기술을 보급시키는 일만 남았다. BTRS, 바이노럴 렌더링 기술을 바탕으로, 메타버스를 이용하는 개인 콘텐츠 창작자까지 가우디오랩의 음향 기술을 쉽게 사용할 수 있도록 소프트웨어 등의 형태로 보급할 계획이다.[12]

㈜디지소닉

㈜디지소닉은 공간음향기술(Spatial Audio Tech) 스타트업 기업이다. 초실감오디오 스타트업 디지소닉은 2020년 1월 구글(google) 본사와 인바운드 서비스(ISA) 계약을 체결했다. 또한 2020년 12월 31일에는 코로나 팬데믹 상황에서 비대면 콘텐츠를 생생하게 즐길 수 있도록 초실감 오디오 솔루션을 개발하여 상용화한 공로를 인정받아 문화체육관광부 장관 표창을 수상했다. 차세대 실감 오디오 기술 산업은 200조 원이 넘는 산업 규모로 게임, 비대면 공연 산업 및 OTT 산업, 5G 기반 XR 산업, 자율주행차 산업, 디지털 헬스케어 산업 등 광범위하게 확산되고 있다. 국내 차세대 음향 기술은 99% 미국, 독일, 일본 등의 기술에 종속되어 수조 원의 기술 라이센스를 지급하고 있다. 선진국형 반도체 강국은 오디오 원천 기술도 뛰어난 데 반해 국내 산업만 기형적으로 낙후되어 있는 것이다. 2020년 9월 문재인 대통령은 디지털 콘텐츠 핵심 기술을 선도해 나가야 한다며 디지소닉의 글로벌 성과를 언급한 바도 있다. 디지소닉의 초실감오디오 기술은 중소벤처기업부의 TIPS 지원 프로그램으로 상용화되었다. 또한 2020년 12월 월트 디즈니 컴퍼니(The Walt Disney Company)의 전 회장 딕쿡(Dick Cook)이 포함된 메이커스(MAKERS) 엔젤투자조합으로부터 A 투자 라운드로 해외 투자를 유치했다. 이 투자는 IP 액셀레이터 펀드인 만큼 오로지 기술력과 미래 성장 가치만을 보고 결정한 것으로, 국내 실감 콘텐츠 기업이 세계 콘텐츠 시장 리더에게 인정받은 첫 사례로 꼽힌다.[13]

비교

오디오에서 아날로그와 디지털은 각각 장단점이 있다. 현재는 디지털 기술이 대세를 이루고 있지만, 여전히 마이크에서 스피커에 이르는 연결고리 중 특정 부분은 아날로그 기술에 의존하고 있다. 디지털 기술의 가장 큰 장점은 복사이다. 아날로그 복사와 달리 디지털 복사는 신호의 열화가 없기 때문이다. 아날로그와 디지털 기술의 가장 큰 차이는 진폭을 표현하는 방법에 있다. 아날로그는 음파의 진폭을 유사하게 표현하기 때문에 원음과 재생음, 그리고 녹음 매체에 담겨 있는 음이 일종의 비례 관계를 형성한다. 아날로그에서 디지털로의 변환은 표본화(sampling)와 양자화(quantization)의 과정을 거친다. 표본화는 아날로그 파형을 디지털 형태로 변환하기 위해 표본을 취하는 것을 의미하는데, 표본화 율(sampling rate)은 1초 동안 취한 표본의 수를 의미하며, 단위는 주파수와 같은 헤르츠를 사용한다. CD는 44.1kHz의 표본화 율을 가지는데, 이는 아날로그 파형에서 1초에 4만 4,100개의 표본 샘플을 취했다는 의미다. 표본화 율이 높을수록 원음에 가까운 음으로 디지털화되지만, 데이터의 양은 증가한다. 양자화는 표본화한 샘플을 디지털 형태로 표현할 때, 어느 정도의 정밀도를 가지고 표현할 것인지를 의미한다. 즉 표준화된 각 샘플에서 실제 값을 표현하기 위한 비트 수를 의미한다. CD는 16비트 값으로 양자화를 수행하는데, 이는 디지털화한 샘플의 값을 6만 5,536단계로 표현한다는 의미다. 양자화가 될 때 낮은 표본화와 양자화를 사용하면 복원된 파형에서 많은 오류가 발생하지만, 높은 표본화 율과 양자화를 이용하면 아날로그 · 디지털 변환에 따라 오류를 제거할 수 있다.[2]

각주

- ↑ 〈오디오〉, 《네이버 지식백과》

- ↑ 2.0 2.1 〈다양한 오디오 기술의 변천사〉, 《네이버 지식백과》

- ↑ 〈오디오 부호화 기술의 분류〉, 《네이버 지식백과》

- ↑ 〈무손실 부호화〉, 《네이버 지식백과》

- ↑ 〈공간 오디오 부호화 기술의 원리〉, 《네이버 지식백과》

- ↑ 6.0 6.1 6.2 장대영 연구원 외 4인, 〈실감방송을 위한 3차원 오디오 기술〉, 《한국전자통신연구원》

- ↑ 〈생활 속의 오디오 기술〉, 《네이버 지식백과》

- ↑ 8.0 8.1 8.2 노형미(october18), 〈체감형 미디어 서비스를 위한 공간음향 기술 동향 (기술동향자료)〉, 《한민족과학기술자네트워크》, 2019-06-04

- ↑ 장대영, 이태진 연구원, 〈객체기반 실감음향 기술 개발〉, 《한국전자통신연구원》

- ↑ 장대영 연구원 외 3인, 〈고현장감 오디오 서비스를 위한 하이브리드 오디오 기술동향〉, 《한국전자통신연구원》, 2016-06

- ↑ 이상오 기자, 〈(4차 산업혁명 주요기술) 소리도 ‘입체적으로’ 듣는다…VR 오디오〉, 《공학저널》, 2019-03-13

- ↑ 홍승해 기자, 〈메타버스, 오디오 기술이 승패 가른다〉, 《포춘코리아》, 2021-11-12

- ↑ 〈초실감오디오 스타트업 ‘디지소닉’, 헐리우드 거장으로부터 인정받아〉, 《파이낸셜뉴스》, 2021-03-19

참고자료

- 〈오디오〉, 《네이버 지식백과》

- 〈오디오 부호화 기술의 분류〉, 《네이버 지식백과》

- 〈다양한 오디오 기술의 변천사〉, 《네이버 지식백과》

- 〈생활 속의 오디오 기술〉, 《네이버 지식백과》

- 〈공간 오디오 부호화 기술의 원리〉, 《네이버 지식백과》

- 〈무손실 부호화〉, 《네이버 지식백과》

- 장대영, 이태진 연구원, 〈객체기반 실감음향 기술 개발〉, 《한국전자통신연구원》

- 이상오 기자, 〈(4차 산업혁명 주요기술) 소리도 ‘입체적으로’ 듣는다…VR 오디오〉, 《공학저널》, 2019-03-13

- 홍승해 기자, 〈메타버스, 오디오 기술이 승패 가른다〉, 《포춘코리아》, 2021-11-12

- 노형미(october18), 〈체감형 미디어 서비스를 위한 공간음향 기술 동향 (기술동향자료)〉, 《한민족과학기술자네트워크》, 2019-06-04

- 〈초실감오디오 스타트업 ‘디지소닉’, 헐리우드 거장으로부터 인정받아〉, 《파이낸셜뉴스》, 2021-03-19

- 장대영 연구원 외 3인, 〈고현장감 오디오 서비스를 위한 하이브리드 오디오 기술동향〉, 《한국전자통신연구원》, 2016-06

- 장대영 연구원 외 4인, 〈실감방송을 위한 3차원 오디오 기술〉, 《한국전자통신연구원》

같이 보기

해시넷

해시넷